NVIDIA提出 Tied-Lora:提高LoRA方法的参数效率 用13%参数实现性能与标准LoRA方法相媲美

**划重点:**

1. 🚀 NVIDIA的研究人员开发了一种名为Tied-LoRA的新技术,旨在提高LoRA方法的参数效率。

2. 🔄 Tied-LoRA通过权重绑定和选择性训练,寻找性能和可训练参数之间的最佳平衡。

3. 📊 在不同任务和基础语言模型上进行的实验证明,Tied-LoRA可以在只使用标准LoRA方法13%的参数的情况下实现可比较的性能。

一组来自NVIDIA的研究人员近日提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。该方法采用了权重绑定和选择性训练的策略,以寻找性能和可训练参数之间的最佳平衡。

最近,对于参数高效微调技术的不断进展包括LoRA,通过低秩矩阵逼近减少可训练参数。AdaLoRA是LoRA的扩展,引入了动态秩调整,并将适配器调整与LoRA相结合。另一种技术是由Kopiczko提出的VeRA,通过冻结矩阵和可训练的缩放向量减少参数。QLoRA使用量化的基础模型实现内存高效的LoRA。该研究对低秩权重矩阵应用权重绑定,进一步增强了参数效率。

为了解决为下游任务对语言模型进行微调的计算开销,Tied-LoRA是一种结合了权重绑定和选择性训练的新方法,旨在提高LoRA的参数效率。通过在不同研究和基础语言模型上进行系统实验证明,研究人员确定了一个特定的Tied-LoRA配置,其性能可与标准LoRA方法相媲美,但只使用了13%的参数。

Tied-LoRA是一种通过将权重绑定和选择性训练结合起来,增强LoRA方法参数效率的方法。它通过将权重绑定应用于LoRA中的低秩矩阵,使基础语言模型中的各层共享相同的后果,从而降低了可训练参数的数量。

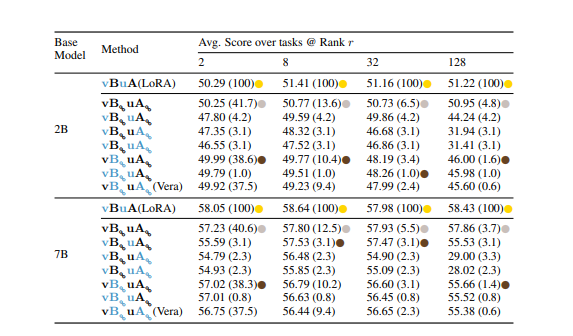

该方法探索了参数训练/冻结和权重绑定的各种组合,以实现性能和可训练参数之间的最佳平衡。在不同任务和两个基础语言模型上进行的实验中,不同的Tied-LoRA配置展示了效率和性能之间的权衡。特定的Tied-LoRA配置vBuA在性能方面表现优异,相较于其他配置减少了87%的参数。在抽取式问答、摘要和数学推理等任务的评估中,展示了Tied-LoRA在提高参数效率的同时显著保持了竞争性能。

通过在各种任务上进行实验后,发现Tied-LoRA是一种通过利用权重绑定和选择性训练增强LoRA方法参数效率的新范例。

结果表明,Tied-LoRA可以替代通识NLI、抽取式QA和摘要等功能。此外,它在不影响性能的情况下提供了改进的参数效率,仅使用标准LoRA的13%的参数。然而,讨论与其他参数效率方法的限制和比较对于确定未来探索的潜在领域至关重要。

论文网址:https://arxiv.org/abs/2311.09578

- 0000

- 0000

- 0000

- 0000

- 0000