微软Orca 2完胜!推理能力与5-10倍大小的模型相当

站长网2023-11-23 14:44:453阅

要点:

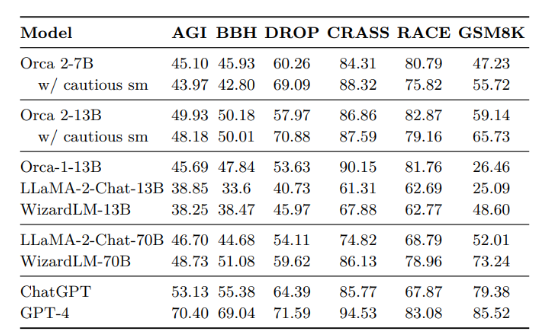

1、Orca2是一个13亿参数的语言模型,通过增强的训练信号提高了小型语言模型的推理能力,与5-10倍于其大小的模型相比具有相当甚至更好的性能。

2、Orca2旨在教导小型语言模型利用一系列推理技巧,并帮助其确定适合特定任务的最有效推理策略。

3、Orca2通过采用谨慎推理技术,即 Prompt Erasure,不仅可以执行具体的推理步骤,还可以在更高层面上制定任务处理策略。

微软研究团队推出的13亿参数模型 Orca2在近期发布的一篇论文中探索了如何提升小型语言模型的推理能力。通过增强的训练信号,Orca2能够在与其大小相似的模型中取得与5-10倍更大的模型相媲美甚至更好的性能。

Orca2的目标是教导小型语言模型采用一系列推理技巧,并帮助其确定对于特定任务最有效的推理策略。与其前身 Orca1类似,研究团队借鉴了更强大的大型语言模型的推理策略,并根据小型模型的能力进行了细致调整。

Orca2采用了一种谨慎推理技术,即 Prompt Erasure,使其成为一种谨慎的推理者。这种技术使模型不仅能够执行具体的推理步骤,还能够在更高层面上制定任务处理策略。与盲目模仿强大的大型语言模型不同,研究团队将其视为行为库,从中精心选择适合当前任务的行为。

在实证研究中,研究人员对 Orca2在15个基准测试中进行了全面评估,涵盖了约100个任务和超过36,000个独特提示。结果显示,Orca2在与其大小相似的模型上明显优于它们,甚至在需要高级推理的任务上与5-10倍更大的模型相媲美甚至超过。

这项工作标志着推动小型语言模型推理能力的重要一步。研究团队相信,提升小型模型的能力将为不同的应用部署场景开辟新的可能,并在效率和功能之间找到平衡。

0003

评论列表

共(0)条相关推荐

- 0001

- 0000

- 0000

- 0000

- 0000