谷歌、英特尔、英伟达在生成式人工智能训练领域展开较量

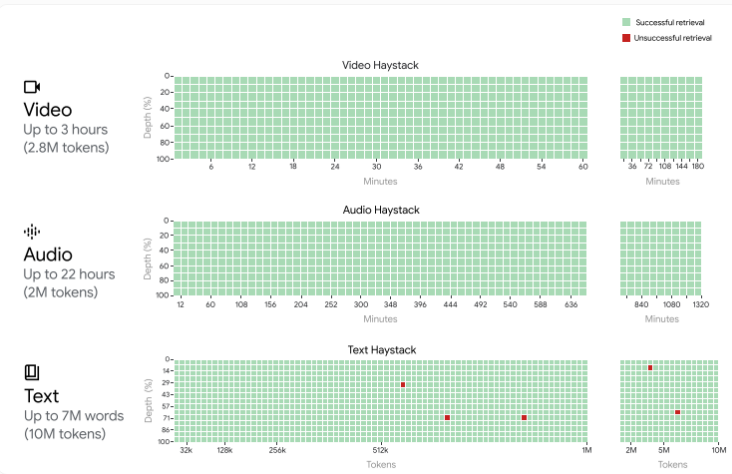

最近,作为计算机系统训练机器学习神经网络能力的公开标准测试,MLPerf 已全面步入生成型人工智能(AI)时代。

今年早些时候,MLPerf 增加了一个针对训练大型语言模型(LLM)的测试,特别是 GPT-3。本月,它又添加了一个基于文本生成图像的测试——Stable Diffusion。搭载英伟达和英特尔处理器的计算机接受了这一新基准的挑战。此外,在训练 GPT-3 的领域,这两个竞争对手还迎来了谷歌的加入。

所有三家公司都投入了庞大的系统来完成这一任务——其中,英伟达的 10,000 GPU 超级计算机是迄今为止测试过的最大系统——这种规模对于生成型 AI 来说是必要的。即便是英伟达最大的系统,也需要工作八天才能完成其 LLM 任务。

总体而言,19 家公司和机构提交了 200 多个结果,显示出过去五个月以来 2.8 倍的性能提升,以及自 MLPerf 成立五年来 49 倍的增长。

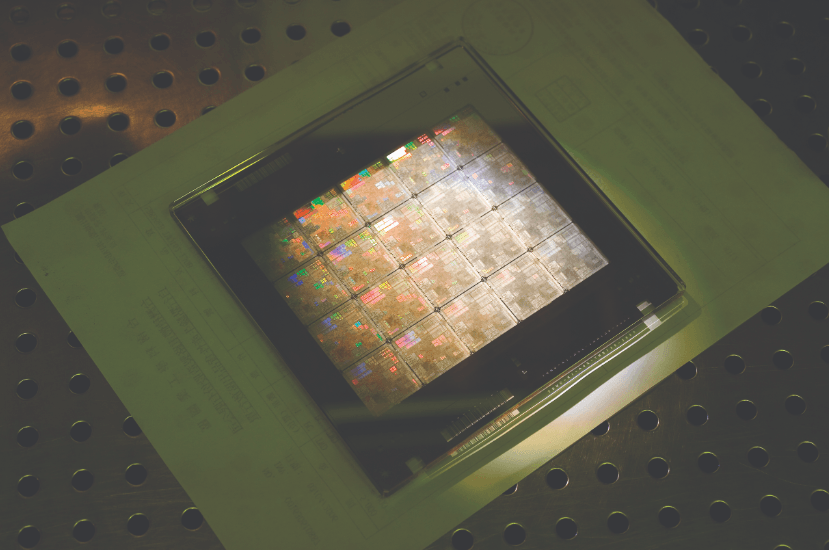

英伟达继续以其 H100 GPU 构建的系统主导 MLPerf 基准测试。然而,最引人注目的是来自公司新的 10,752-GPU AI 超级计算机 Eos 的结果。Eos 在不到 4 分钟的时间内完成了 GPT-3 训练基准的任务。微软的云计算部门 Azure 测试了同等规模的系统,仅落后 Eos 几秒钟。(Azure 支持 GitHub 的编码助手 CoPilot 和 OpenAI 的 ChatGPT。)

Eos 的 GPU 能够实现总计 42.6 亿亿次浮点运算(exaflops),并且通过 Nvidia 的 Quantum-2 Infiniband 互联技术,实现了每秒 1.1 百万亿字节的传输速度。英伟达 AI 基准测试和云计算总监 Dave Salvatore 表示:「这些速度和数据的规模令人震惊,这是一台极其强大的机器。」

Eos 将绑定到单一机器中的 H100 GPU 数量增加了三倍。这三倍的增长获得了 2.8 倍的性能提升,或 93% 的扩展效率。高效的扩展是持续改进生成型 AI 的关键,这些 AI 每年都在以 10 倍的速度增长。

Eos 应对的 GPT-3 基准测试并非 GPT-3 的完整训练,因为 MLPerf 希望多家公司都能够达到这一水平。相反,它涉及将系统训练到一个特定的检查点,证明给予足够时间,训练将达到所需的准确性。而这些训练确实需要时间。从 Eos 的 4 分钟结果推断,完成训练需要 8 天,而这或许是迄今为止建造的最强大的 AI 超级计算机。相比之下,一个更为合理大小的计算机——搭载 512 个 H100 的系统——将需要 4 个月的时间。

与此同时,英特尔也在逐步缩小差距。英特尔提交了使用 Gaudi 2 加速器芯片的系统结果,以及仅依赖其第四代至强 CPU 的系统结果。与上一轮训练基准相比,最大的变化是公司启用了 Gaudi 2 的 8 位浮点(FP8)功能。在过去 10 年中,使用低精度数字(如 FP8)是 GPU 性能大幅提升的主要原因。在 GPT-3 和其他 Transformer 神经网络的部分环节中使用 FP8,已经在英伟达的 H100 结果中显示出其价值。现在,Gaudi 2 也看到了性能提升。

英特尔 Habana Labs 的首席运营官 Eitan Medina 表示:「我们预计启用 FP8 将带来 90% 的性能提升。我们交付的成果超出了预期——384 加速器集群的训练时间缩短了 103%。」

这一新结果使得 Gaudi 2 系统的速度略低于英伟达系统的三分之一,并且是谷歌 TPUv5e 的三倍。在新的图像生成基准测试中,Gaudi 2 的速度也大约是 H100 的一半。这一轮,FP8 仅启用于 GPT-3 基准测试,但 Medina 表示他的团队目前正在为其他测试开启 FP8。

Medina 继续强调,与 H100 相比,Gaudi 2 在价格方面有显著优势,因此在价格和性能的综合指标上具有优势。Medina 预计,随着英特尔下一代加速器芯片 Gaudi 3 的推出,这一优势将会增长。Gaudi 3 将于 2024 年投入大规模生产,采用与英伟达 H100 相同的半导体制造工艺。

此外,英特尔还提交了仅基于 CPU 的系统结果。再次展示了多个基准测试中训练时间从几分钟到几小时不等的情况。除了 MLPerf 基准测试之外,英特尔还分享了一些数据,显示一个包含 AMX 矩阵引擎的 4 节点至强系统可以在不到五分钟内微调图像生成器 Stable Diffusion。微调是指对已经训练好的神经网络进行专门化,以适应特定任务。例如,英伟达的芯片设计 AI 是对现有大型语言模型 NeMo 的微调。

您可以在此处查看所有结果。

- 0000

- 0000

- 0004

- 0000

- 0000