北大&智源提出训练框架LLaMA-Rider 让大模型自主探索开放世界

站长网2023-11-07 12:06:100阅

要点:

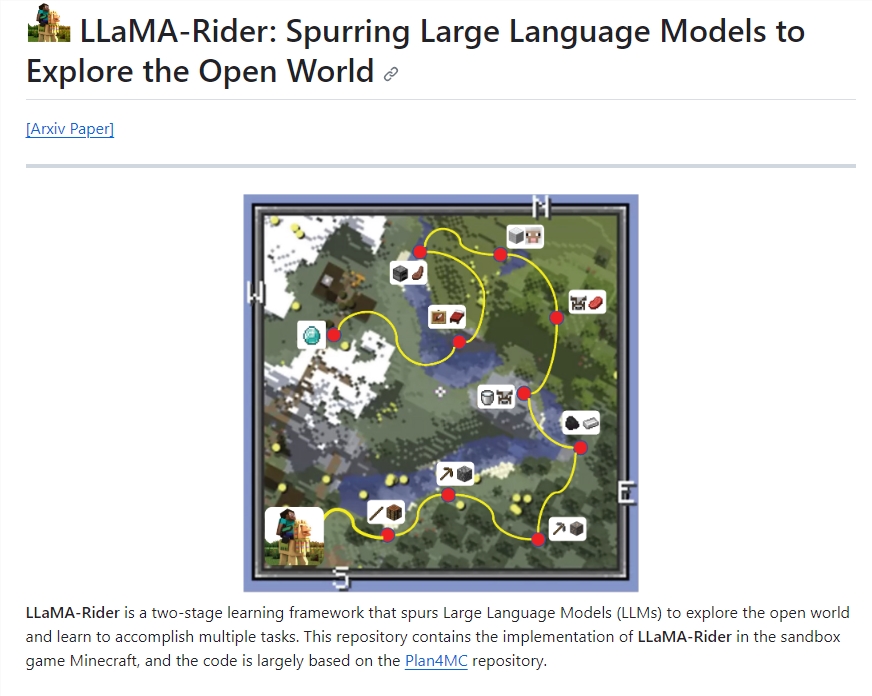

1. LLaMA-Rider是一个训练框架,赋予大型语言模型在开放世界中自主探索、学习任务的能力,提高其适应开放环境的通用智能。

2. LLaMA-Rider采用反馈-修改机制进行主动探索,在探索阶段将成功经验整合为监督数据集,然后用于微调模型,提高多任务解决的能力。

3. LLaMA-Rider的实验表现优于其他方法,具有高采样效率和低训练代价,展现了对开放世界的持续学习和多任务解决能力。

北京大学和北京智源人工智能研究院的团队提出了名为LLaMA-Rider的训练框架,旨在让大型语言模型在开放世界中具备自主探索和学习任务的能力。这个框架通过反馈-修改机制来实现主动探索,使模型在环境中接收反馈信息,不断调整决策,从而逐渐适应开放环境。

项目地址:https://github.com/PKU-RL/LLaMA-Rider

LLaMA-Rider采用两阶段训练方法,首先让模型在环境中自主探索,然后将成功经验整合为监督数据集,用于模型微调,提高多任务解决的能力。在实验中,LLaMA-Rider的表现优于传统任务规划器,具有高采样效率和低训练代价,尤其在处理大动作空间和复杂场景时表现出色。

LLaMA-Rider还展现了对新任务的泛化能力,表明模型学到了决策的泛化性。作者还验证了子任务重标记的重要作用,以及模型在任务相关问题中的准确回答,证明了模型在训练过程中学到了与环境知识的对齐。

实验结果显示,LLaMA-Rider在多任务解决上表现出高采样效率和低训练代价,与强化学习方法相比具有优势。这个研究为大型语言模型在开放世界中的自主学习提供了重要思路,具有广阔的应用前景。

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0000

- 0002