微软研究员推LoRAShear技术:高效对大语言模型结构化剪枝

划重点:

- 🚀 LoRAShear:一种高效的LLMs结构化剪枝与知识恢复方法。

- 🧠 LLMs:快速处理文本数据,助力搜索引擎和问答系统。

- 💡 知识更新:微软研究人员提出结构剪枝方法,提高知识保存率。

微软的研究人员近日推出了一项名为LoRAShear的创新技术,旨在剪枝大型语言模型(LLMs)并实现知识的高效恢复。LLMs在处理文本数据和迅速检索相关信息方面表现出色,广泛应用于搜索引擎和问答系统。这项技术的问世将有望帮助用户更轻松地找到所需信息,极大地促进了人工智能的发展。

在LLMs的日常维护工作中,知识的更新和恢复是至关重要的任务之一。目前,一种常见的知识更新方法是通过精细调整(fine-tuning)。开发人员可以取得一个预训练的模型,然后在特定数据集上进行精细调整,从而更新其知识。这使得模型能够了解最新事件或特定领域的信息,为研究人员和专业人士提供了有力的工具。

微软的研究人员在这一领域取得了新的突破,他们开发了LoRAShear技术,这是一种高效的LLMs剪枝与知识恢复方法。所谓的“剪枝”是指通过移除或减少神经网络架构中的某些组件或元素,从而使其更加高效、紧凑和计算要求更低。

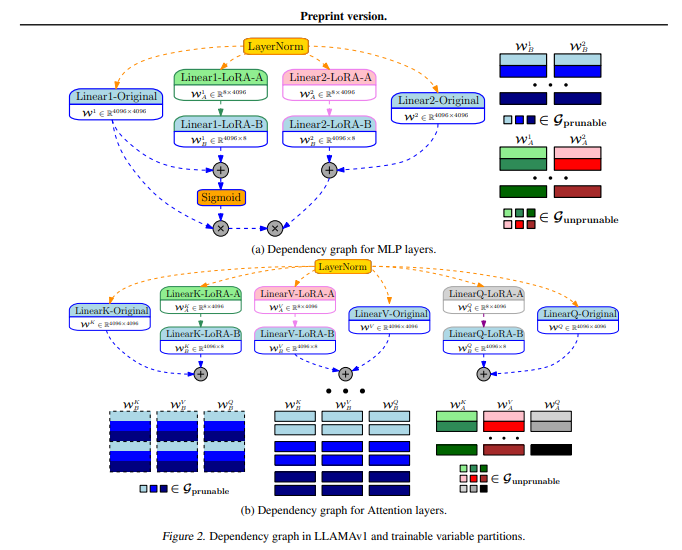

LoRAShear采用了Lora Half-Space Projected Gradient(LHSPG)方法,实现了渐进式结构剪枝,实现知识的高效传递,同时引入了动态知识恢复阶段,使其在预训练和指导性微调的方式下执行多阶段的精细调整。

研究人员表示,LoRAShear技术可以应用于通用的LLMs,通过分析LLMs与LoRA模块的依赖图,实现结构剪枝和知识恢复。他们提出了一种独特的算法,用于创建原始LLMs和LoRA模块的依赖图,还引入了一种结构稀疏优化算法,利用LoRA模块的信息来更新权重,从而提高了知识的保存率。

LoRAPrune技术将LoRA与迭代结构剪枝相结合,实现了高效的参数微调和直接硬件加速。他们表示,这种方法在内存使用效率上非常高,仅依赖于LoRA的权重和梯度来进行剪枝标准。

研究人员通过在开源LLAMAv1上实施LoRAShear技术来证明其有效性,他们发现,20%的LLAMAv1剪枝后,性能下降了1%,而50%的剪枝模型在评估基准上保持了82%的性能。

尽管LoRAShear技术在LLMs的知识恢复方面取得了显著的进展,但仍然面临着大规模计算资源的需求和缺乏预训练和指导性微调数据集的挑战。未来的工作将集中在解决这些挑战,为人工智能领域的发展提供更多的支持。

论文网址:https://arxiv.org/abs/2310.18356

- 0001

- 0000

- 0000

- 0003

- 0000