谷歌DeepMind研究:Transformer模型无法超越训练数据进行泛化

站长网2023-11-06 14:36:430阅

要点:

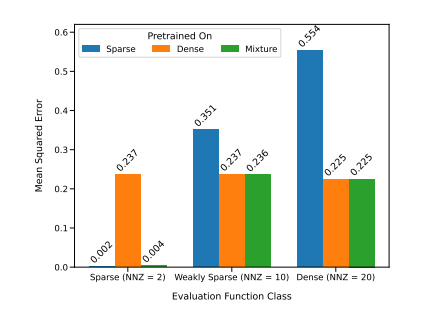

1. 谷歌DeepMind的研究人员进行了实验,研究Transformer模型是否能够在超出预训练数据范围之外泛化出新的认知和能力,他们得出结论认为几乎不可能。

2. 研究关注了预训练过程中使用的数据对Transformer模型的少样本学习能力的影响,发现模型在上下文学习过程中可以在预训练的函数类别中进行模型选择,但难以超出其预训练数据的范围。

3. 实验还展示了模型在处理不同函数类别混合的情况下的性能,以及在处理未见过的函数和极端版本的函数时的局限性,指出模型的模型选择能力受到预训练数据的接近程度限制。

谷歌DeepMind的研究人员进行了实验,旨在探讨Transformer模型是否能够在超出预训练数据范围之外泛化出新的认知和能力。他们的研究发现,几乎不可能要求模型在超出预训练数据范围之外解决新问题。

研究侧重于探讨预训练过程中使用的数据对模型的少样本学习能力的影响,结果显示模型在上下文学习过程中可以在预训练的函数类别中进行模型选择,但难以超出预训练数据的范围。

论文地址:https://arxiv.org/pdf/2311.00871.pdf

实验还涵盖了模型在处理不同函数类别混合的情况下的性能,并指出模型在处理未见过的函数和极端版本的函数时存在一些限制,表明模型的模型选择能力受到与预训练数据的接近程度的限制。

这一研究强调了预训练数据对于模型性能的重要性,强调了数据质量对于模型的关键作用。虽然Transformer模型在某些情况下能够在预训练的函数类别中进行模型选择,但其泛化能力在处理新问题和函数类别时存在限制。这些发现有助于深入理解Transformer模型的局限性,特别是在超越预训练数据范围时。这对于机器学习和人工智能领域的研究和发展具有重要意义。

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0000

- 0000