腾讯和香港科技大学开源视频生成模型VideoCrafter1 超越其他开源模型

站长网2023-11-01 11:35:020阅

腾讯和香港科技大学最近合作推出了一种全新的视频生成模型VideoCrafter,用于高质量视频生成。这个模型包括视频VAE和3D去噪U-net,经过在庞大的数据集上进行了训练,其性能表现出色,超过了其他开源视频生成模型。

该项目旨在创建一个高级且用户友好的视频生成模型,以满足研究和生产的需求,并为社区的发展做出贡献。他们还设想了一个视频创作助手,能够通过视觉创作将想象的点子变为现实。

项目地址:https://ailab-cvc.github.io/videocrafter/

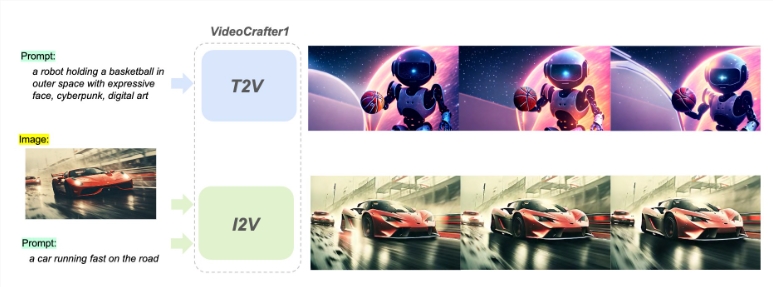

VideoCrafter1提供了两种开放扩散模型,分别用于文本到视频(T2V)和图像到视频(I2V)任务。T2V模型能够生成具有1024×576分辨率的逼真且具有电影质量的视频,在质量方面胜过其他开源T2V模型。而I2V模型则旨在生成与提供的参考图像内容严格一致的视频,保留其内容、结构和风格。这是第一个能够将给定图像转化为视频剪辑并保持内容保存约束的开源I2V基础模型。

该项目的视频扩散模型框架利用自动编码器的潜在空间中训练视频UNet,以FPS作为条件来控制生成视频的运动速度。对于T2V模型,只需将文本提示通过交叉关注(feed into the spatial transformer)输入即可,而对于I2V模型,则将文本和图像提示一同输入。

此外,他们提供了EvalCrafter进行综合评估。项目鼓励使用其代码、模型和数据的研究引用,并采用Apache2.0许可分发其代码、模型和数据。

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0001

- 0000

- 0000