GPT-4超豪华套餐上线,全新32K模型遭泄密!文件上传分析,模型自动选择,绝杀千家AI公司

【新智元导读】ChatGPT重磅级更新又来了!这次,直接可以读取PDF文件,而且不用选择模型,就能自动识别需要的功能。另外,有网友爆料称,GPT-4正在训练全新32k模型「copilot-gpt-4-2」,数据截至2023年3月。

一夜之间,上千家初创公司,全被OpenAI干倒了!

没错,GPT-4昨夜又悄悄更新了,惊艳了所有人。

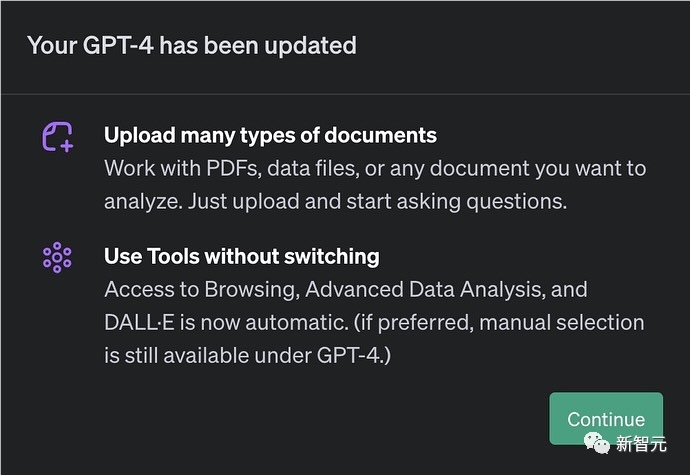

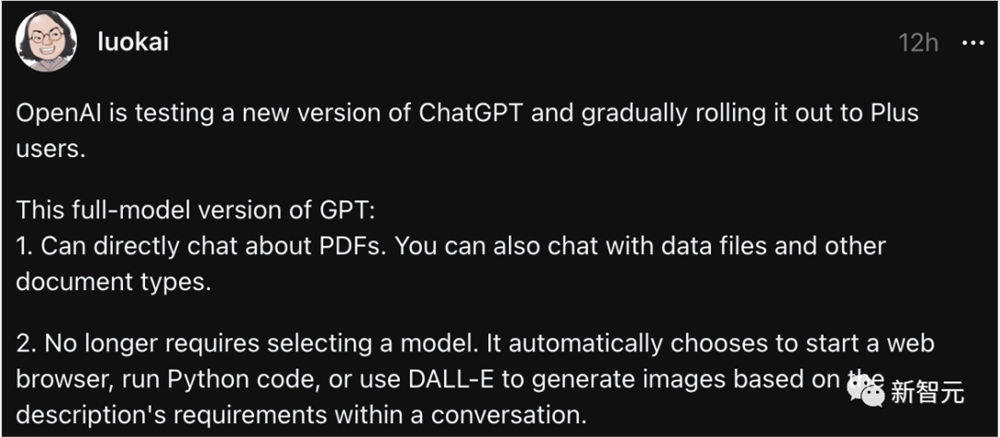

现在,GPT-4可以直接与PDF聊天,甚至还可以与数据文件和其他文档类型聊天。

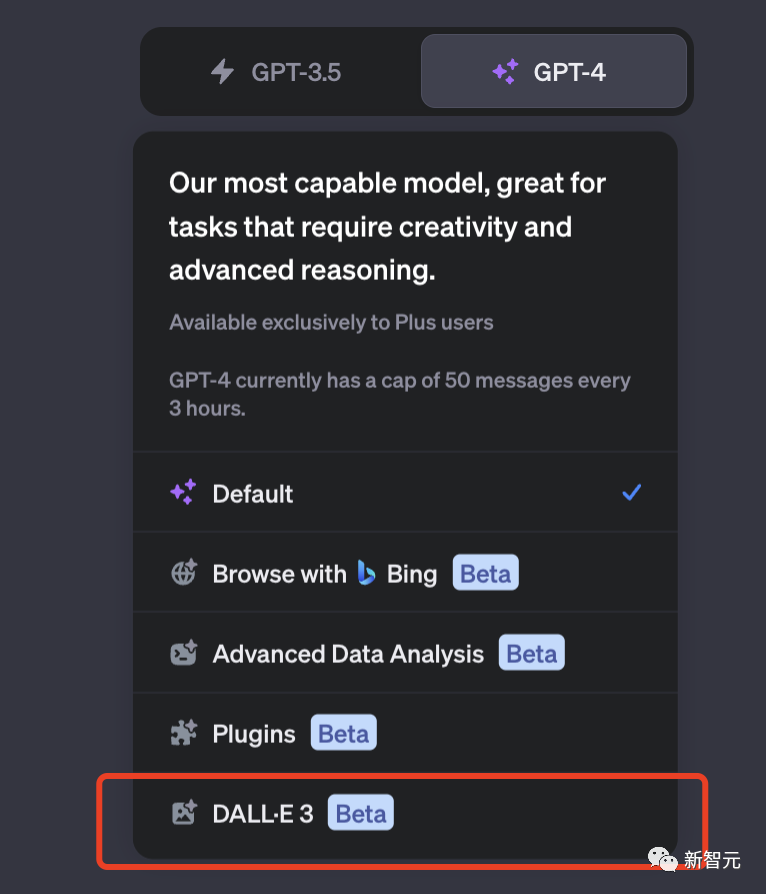

另外,你再也不需要从GPT-4的下拉菜单中选择需要哪个模型了。

GPT-4会根据对话中的描述要求,自动选择打开必应网络浏览器、运行Python代码或使用DALL·E生成图像。

目前,这个全模型版本的GPT-4正在测试,并逐步向Plus用户推出。

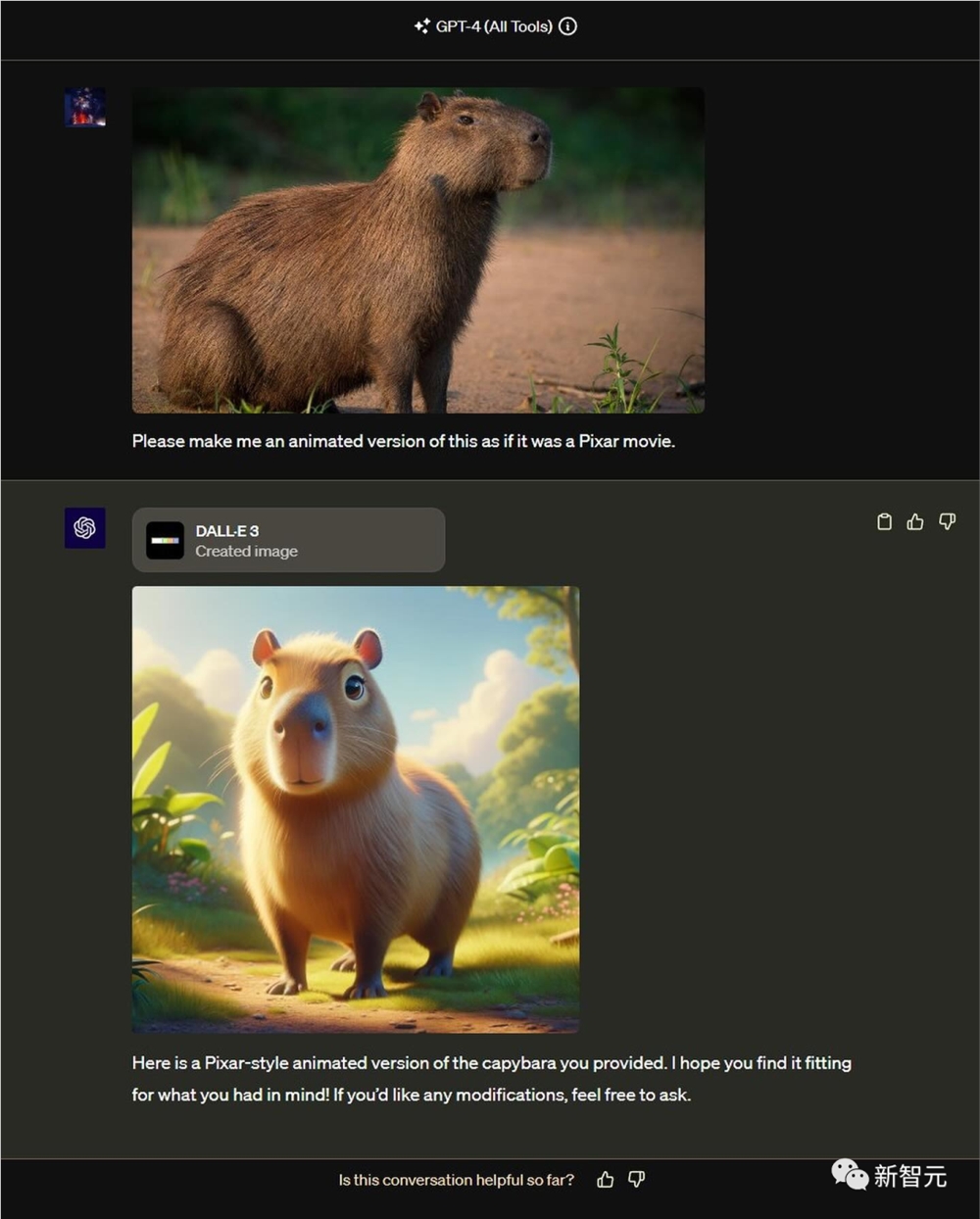

9月的时候,DALL·E3首次集成到ChatGPT后,初次解禁了多模态能力。

而现在,GPT-4已经完完全全拥有多模态能力了。

OpenAI一更新,千家初创公司就要倒闭。简单来说,ChatGPT的战略,就是整合、创新和主导。

而ChatGPT,终将成为一个为集Midjourney、PDF Chat、Perplexity AI和高级数据分析于一体的「AI超级应用程序」。

网友抢先体验

新功能上线,当然少不了一波网友的试玩。

一部分ChatGPT Plus会员,已经可以试用新的测试版功能了,包括上传文件、处理文件、多模态支持。

其实,这个功能并不新鲜。以前,它隐藏在高级数据分析模型中,我们必须从模型切换器中选择该模型,才能获得文件上传按钮。

而现在,文件可以直接上传了!

给GPT-4喂一份文件,让它做个总结,查找具体信息时,说句话就可以实现了。

另外,现在让GP4-4画画,也不用动手选模型了。

在文本输入框,一句话就能直接调用DALL-E3的插件。

简单来说,GPT-4会根据你的需求,自动选择合适的模型。

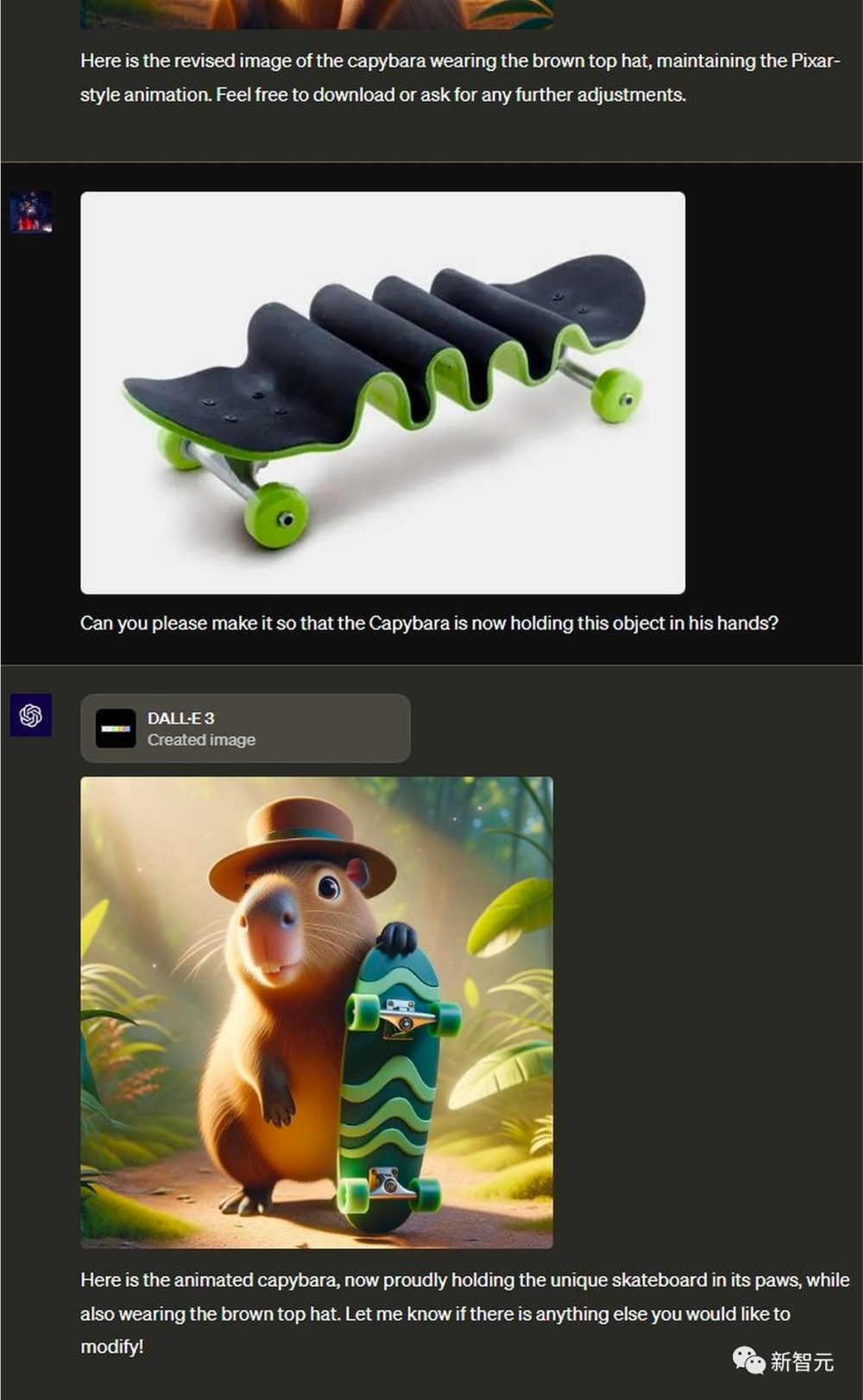

你还可以边交流边创作,可以把两幅图元素结合,就得到了拿着滑板车的水豚。

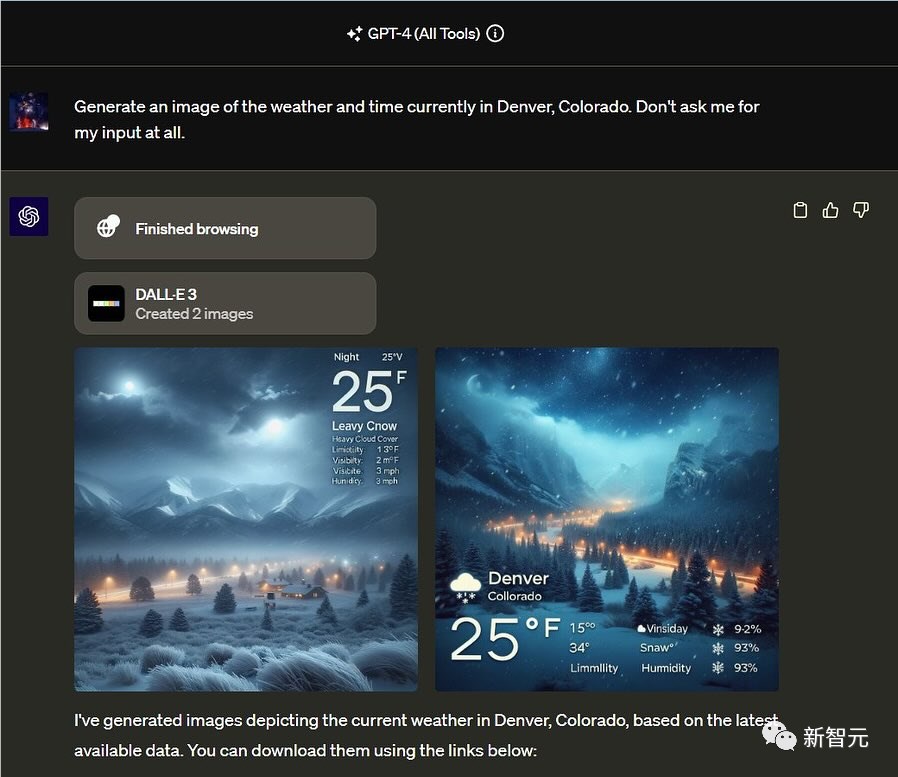

更让你想不到的是,下一代图像生成技术已经把「ChatGPT网页浏览 DALL·E3」用上了。

无需在不同页面间切换,就能无缝制作大片。

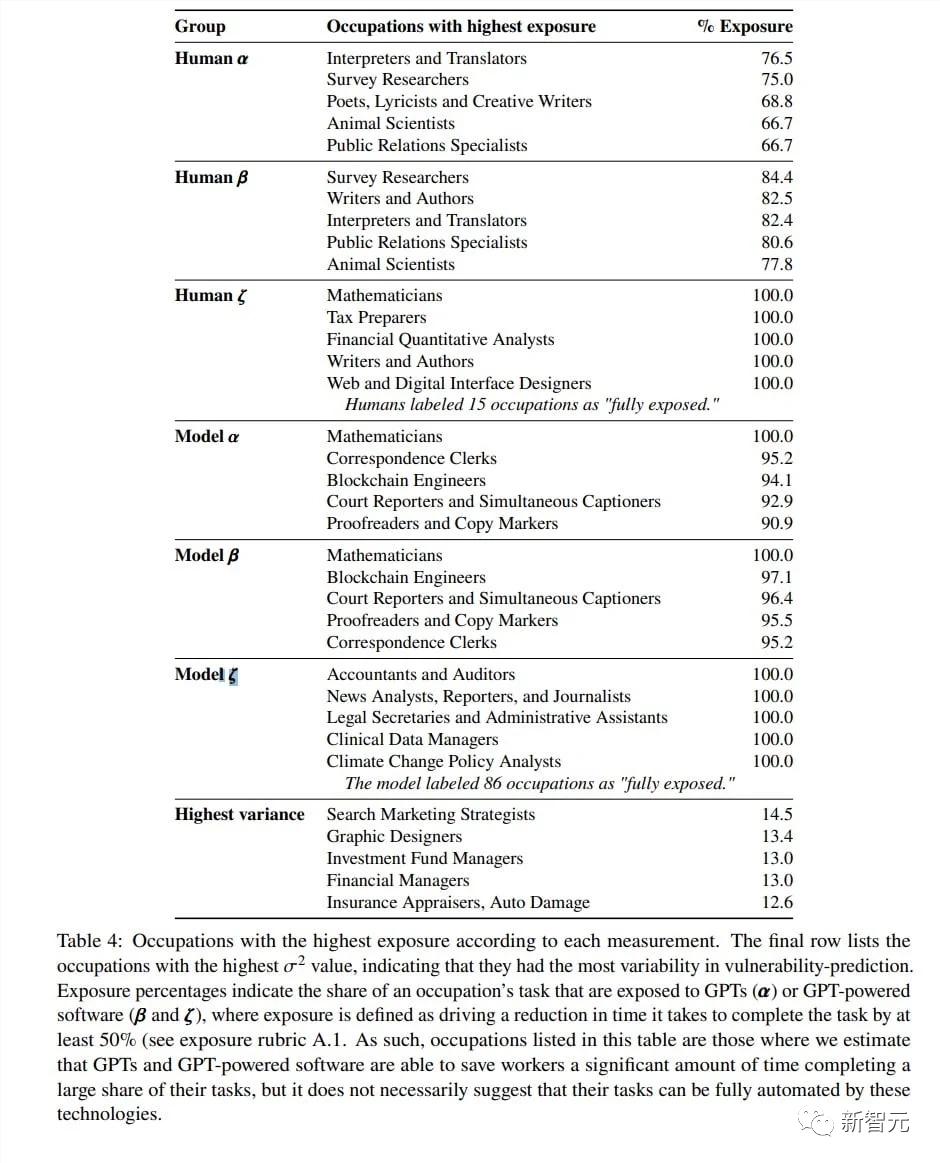

OpenAI、OpenResearch和宾大在今年春天的一项研究中预测,随着工具的使用,像GPT-4这样的大型语言模型将对大约80%的美国工人至少10%的工作产生影响。

对于19%的员工来说,LLM可能会影响至少50%的任务。

而这次GPT-4的超级升级,显然让OpenAI离自己的愿景又近了一步——开发出LLM,让它们能够在能力较弱的领域自主使用工具,从而远超原本训练出的能力。

新版GPT-4模型泄露

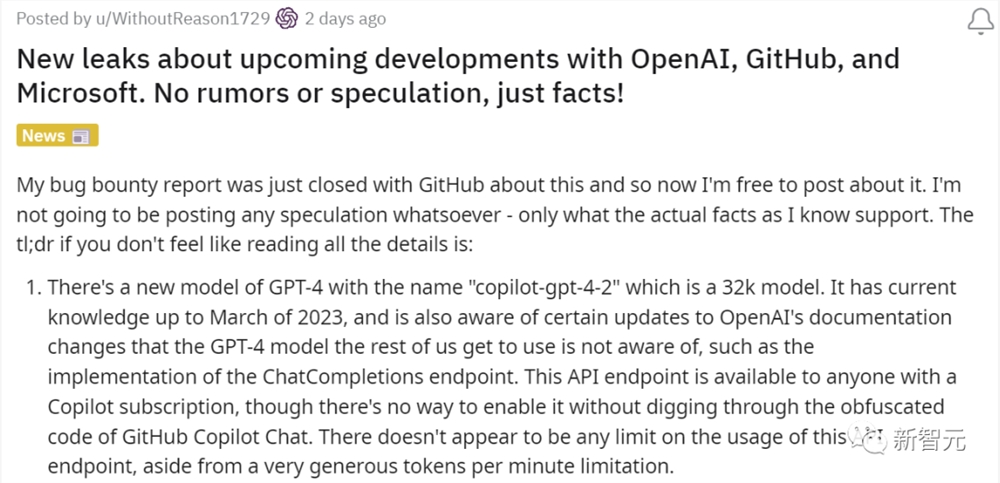

另外,根据Reddit上泄露的信息,OpenAI很可能正在训练一款全新的GPT-4模型——copilot-gpt-4-2。

其中,模型训练数据的截止日期为2023年3月,上下文窗口为32K。

无独有偶,最近有一些用户表示,自己的GPT-4竟然可以访问当前最新的信息。

比如,它知道威尔-史密斯在奥斯卡颁奖典礼上扇了克里斯-洛克一耳光。

不过,由于ChatGPT此前曾出现过关于训练结束日期的「幻觉」,或者错误地引用了系统提示。因此,这类消息的真实性还有待考证。

一种理论认为,这是因为GPT-4基于的是混合专家模型(MoE)。其中的16个联网AI模型,可能具有不同的训练数据,或者正在陆续更新。

在使用时,GPT-4会根据访问和查询的不同,激活不同的模型。而这就可以解释为什么会出现不同的训练日期了。

有网友对发帖人提问道:你确定这是下一代GPT-4的新版本,而不是codex GPT-4吗?或许它是由包含所有 up2date文档的矢量数据库提供支持的?

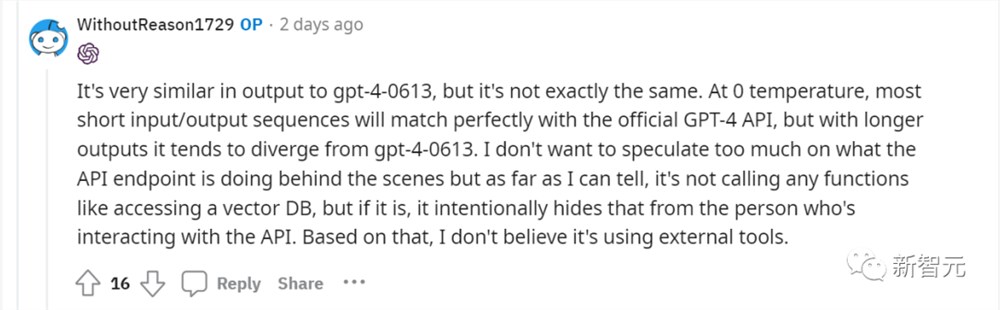

发帖人表示,它的输出与gpt-4-0613非常相似,但并不完全相同。大多数短输入/输出序列将与官方GPT-4API完美匹配,但对于较长的输出,它往往会偏离gpt-4-0613。

它应该没有调用任何函数,比如访问矢量数据库,但如果是的话,它会故意向与API交互的人隐藏它。基于此,它应该没有使用外部工具。

参考资料:

https://www.theverge.com/2023/10/29/23937497/chatgpt-plus-new-beta-all-tools-update-pdf-data-analysis

https://the-decoder.com/chatgpt-might-have-been-updated-with-more-recent-information/

- 0000

- 0000

- 0000

- 0000

- 0000