认识 Mini-DALLE3:Mini-DALLE3:通过提示大语言模型实现交互式文本到图像生成方法

划重点:

- 文本到图像模型的快速发展,但在突破自然语言交流方面仍是挑战。

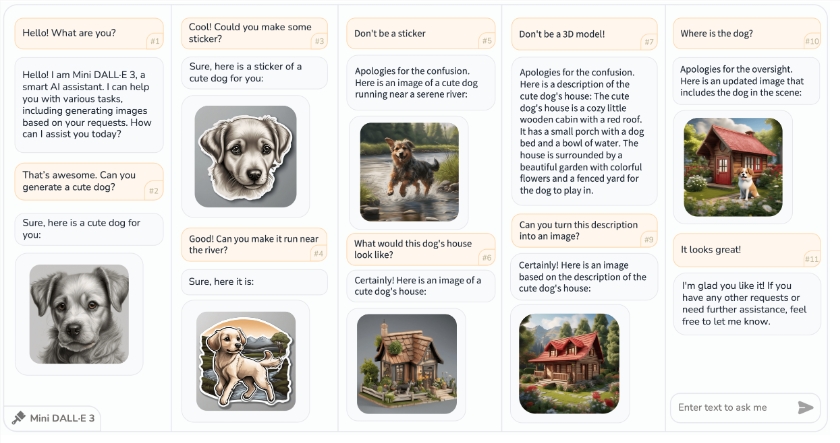

- Mini-DALLE3方法允许用户以自然语言规定图像需求,提供反馈,以及提出建议。

- 该方法通过与大型语言模型互动,改善了图像生成的用户友好性。

人工智能内容生成领域取得了飞速的发展,尤其是在文本到图像模型方面,为生成高质量、多样性和创意丰富的AI生成内容开辟了新时代。然而,与这些先进的文本到图像模型进行有效的自然语言交流一直是一个重要挑战,因为这需要用户具备对提示工程的专业知识。

目前,文本到图像(T2I)模型的最新方法,如Stable Diffusion,在从文本提示生成高质量图像方面取得了显著的进展。然而,它们要求用户创建复杂的提示,包括词组、魔术标签和注释,这限制了这些模型的用户友好性。

此外,现有的T2I模型在理解自然语言方面仍存在局限,导致用户需要掌握模型的特定语言风格才能进行有效交流。此外,T2I管道中的文本和数值配置繁多,包括词语权重、负面提示和风格关键词,这对非专业用户来说可能很复杂。

为了解决这些限制,中国的一个研究团队最近发表了一篇新论文,介绍了一种名为“互动文本到图像”(iT2I)的全新方法。这种方法允许用户与大型语言模型(LLMs)进行多轮对话,使他们能够逐步规定图像需求、提供反馈,并使用自然语言提出建议。

iT2I方法利用提示技术和现成的T2I模型,以增强LLMs的图像生成和优化能力。它通过消除复杂提示和配置的需求,显著提高了用户友好性,使非专业用户也能够使用这些模型。

iT2I方法的主要贡献包括引入了交互式文本到图像(iT2I)作为一种创新方法,它允许用户与AI代理进行多轮对话,进行互动图像生成。iT2I确保了图像的一致性,提供了与语言模型的可组合性,支持各种图像生成、编辑、选择和优化的指令。

该论文还提出了一种增强语言模型用于iT2I的方法,突出了其在内容生成、设计和互动叙事应用中的多功能性,从而最终改善了从文本描述生成图像的用户体验。此外,所提出的技术可以轻松集成到现有的LLMs中。

为了评估这种方法,作者进行了实验,评估了其对LLMs能力的影响,比较了不同的LLMs,并为各种场景提供了实际的iT2I示例。实验考虑了iT2I提示对LLMs能力的影响,并证明它仅具有轻微的影响。商业LLMs成功生成了与文本响应相对应的图像,而开源LLMs显示出不同程度的成功。实际示例展示了单轮和多轮图像生成以及交替的文本-图像叙事,突出了系统的能力。

简单的说,该方法允许用户与AI代理进行多轮对话,从而使图像生成更加用户友好。iT2I增强了语言模型,确保图像的一致性,并支持各种指令。实验结果显示,对语言模型性能的影响很小,使iT2I成为人工智能内容生成领域的一项有前途的创新。

Mini-DALLE3的特色功能包括:

1. 与大型语言模型的互动体验:Mini-DALLE3提供了与DALL•E3和ChatGPT一样的互动和交叉文本到图像和文本到文本的体验。

2. 在对话中生成图像:支持生成嵌入对话中的图像,使得文本与图像的交互更加生动。

3. 支持一次生成多个图像:用户可以选择一次生成多张图像,为创作提供更多可能性。

4. 图像选择功能:Mini-DALLE3允许用户在生成图像时进行选择,增加了用户的参与度。

5. 生成图像的细化:提供了生成图像的细化选项,可以调整图像的细节和风格。

6. 提示细化和变化:支持进一步调整和改变提示,以获取不同风格和结果。

7. 指导经过调整的大型语言模型(LLM/SD):用户可以与经过调整的大型语言模型互动,以获取定制的结果。

这些功能使Mini-DALLE3成为一个强大的文本到图像工具,提供了丰富的创作和交互体验。

项目网址:https://github.com/Zeqiang-Lai/Mini-DALLE3

项目论文:https://arxiv.org/abs/2310.07653v2#

- 0000

- 0000

- 0000

- 0000

- 0000