南加州大学提出通道式轻量级重编码CLR 解决大语言模型灾难性遗忘问题

要点:

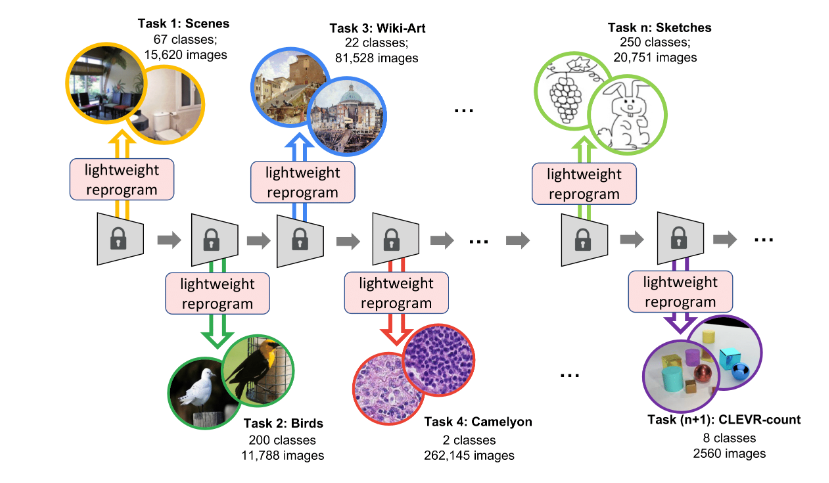

1. 南加州大学和Google Research提出了通道式轻量级重编码(Channel-wise Lightweight Reprogramming)方法,用于解决持续学习问题,通过在固定任务不变的模型背骨干中添加轻量级可训练模块,对每层通道的特征图进行重编程,以适应新任务,仅占0.6%的额外参数。

2. 通道式轻量级重编码方法采用动态网络方式,可以持续学习多个新任务而不会出现灾难性遗忘,使模型在不同任务之间灵活转换。

3. 这项研究的动机是持续学习中的遗忘问题,提出了一种更轻量级但更强大的重编程方法,通过通道线性映射和卷积核的重编码,使模型能够适应多个新任务,实现更好的性能。

在持续学习领域,南加州大学和Google Research提出了一项创新的方法,通道式轻量级重编码(Channel-wise Lightweight Reprogramming,CLR),旨在解决模型在持续学习新任务时出现的灾难性遗忘问题。持续学习的关键挑战是如何在学习新任务后仍然保持对旧任务的性能,而CLR方法提供了一种有前景的解决方案。

与传统的多任务学习不同,持续学习是在一个接一个的任务中进行学习,模型需要逐个适应新的任务,同时尽量避免遗忘之前学到的知识。

论文地址: https://arxiv.org/pdf/2307.11386.pdf

项目地址: https://github.com/gyhandy/Channel-wise-Lightweight-Reprogramming

数据集地址: https://ilab.usc.edu/andy/skill102

CLR的创新之处在于它通过在模型的固定骨干(backbone)中引入可训练的轻量级模块,对每一层的通道特征图进行重编程,使其适用于新任务。这些轻量级模块仅占整个模型的0.6%额外参数,但为每个新任务提供了定制的特征。这意味着模型可以连续学习无数个新任务,而不会受到灾难性遗忘的困扰。

CLR方法采用了动态网络的方式,通过通道线性映射对卷积核产生的特征图进行重编程,实现了多个新任务之间的平滑切换。该方法的灵活性使其在持续学习中表现出色,即使面对众多新任务,每个轻量级模块所需的训练参数仍然非常有限,这使得模型的规模保持相对较小。

CLR方法通过引入轻量级重编程参数,使模型能够以更轻量级但更强大的方式适应不同的新任务。它解决了持续学习中的遗忘问题,为模型提供了更好的性能和灵活性。

通道式轻量级重编码(CLR)方法为持续学习领域带来了新的机会,使模型能够在不断学习新任务的同时,有效地保持对旧任务的性能,为多任务学习领域带来了新的突破。这一创新方法有望为未来的持续学习研究和应用提供更多的可能性。

- 0000

- 0001

- 0000

- 0000

- 0000