突破性文本生成视频方法LVD,利用LLM创建动态场景布局

文章概要:

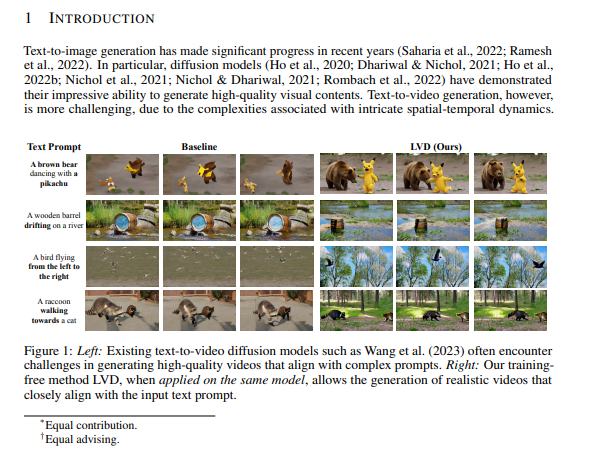

1. 困扰文本提示生成视频的挑战:研究团队引入LLM-Grounded Video Diffusion(LVD)方法,以解决生成复杂时空动态视频的问题。

2. LVD采用大型语言模型(LLMs)来创建动态场景布局(DSLs),作为视频生成的蓝图,同时发现LLMs具有惊人的能力来捕捉时空关系和复杂动态。

3. LVD结果显著优于基本视频扩散模型,为纯文本提示生成与所需属性和运动模式相符的视频,为内容创作和视频生成等应用开辟了新的可能性。

针对从文本提示生成视频所面临的挑战,一支研究团队引入了一种新方法,名为LLM-Grounded Video Diffusion(LVD)。核心问题在于,现有模型难以准确表示文本提示中描述的复杂时空动态。

为了提供背景,文本到视频生成是一项复杂的任务,因为它要求仅基于文本描述生成视频。尽管以前曾尝试解决这个问题,但它们在生成的视频在空间布局和时间动态方面与给定提示的匹配方面通常表现不佳。

然而,LVD采用了一种不同的方法。它不是直接从文本输入生成视频,而是利用大型语言模型(LLMs)首先根据文本描述创建动态场景布局(DSLs)。这些DSLs本质上充当了随后的视频生成过程的蓝图或指南。

尤为引人注目的是,研究人员发现LLMs具有出人意料的能力,可以生成这些DSLs,不仅捕捉了空间关系,还捕捉了复杂的时空动态。这对于仅基于文本提示准确反映现实世界场景的视频生成至关重要。

为了使这个过程更具体,LVD引入了一种算法,利用DSLs来控制视频扩散模型中生成物体级空间关系和时空动态的方式。重要的是,这种方法不需要大量的训练;它是一种无需训练的方法,可以集成到各种具有分类器指导能力的视频扩散模型中。

LVD的结果非常显著。它在生成视频方面明显优于基本视频扩散模型和其他强基线方法,能够忠实地遵循文本提示中所需的属性和运动模式。LVD生成的文本和视频之间的相似性为0.52。不仅如此,文本和视频之间的相似性,以及视频的质量都超越了其他模型。

可见,LVD是一种开创性的文本到视频生成方法,利用LLMs的能力来生成动态场景布局,最终提高了从复杂文本提示生成的视频的质量和保真度。这种方法有潜力在内容创作和视频生成等各种应用中开辟新的可能性。

论文网址:https://arxiv.org/abs/2309.17444

- 0000

- 0000

- 0000

- 0000

- 0000