Hugging Face 大语言模型三大优化技术

站长网2023-10-08 14:33:561阅

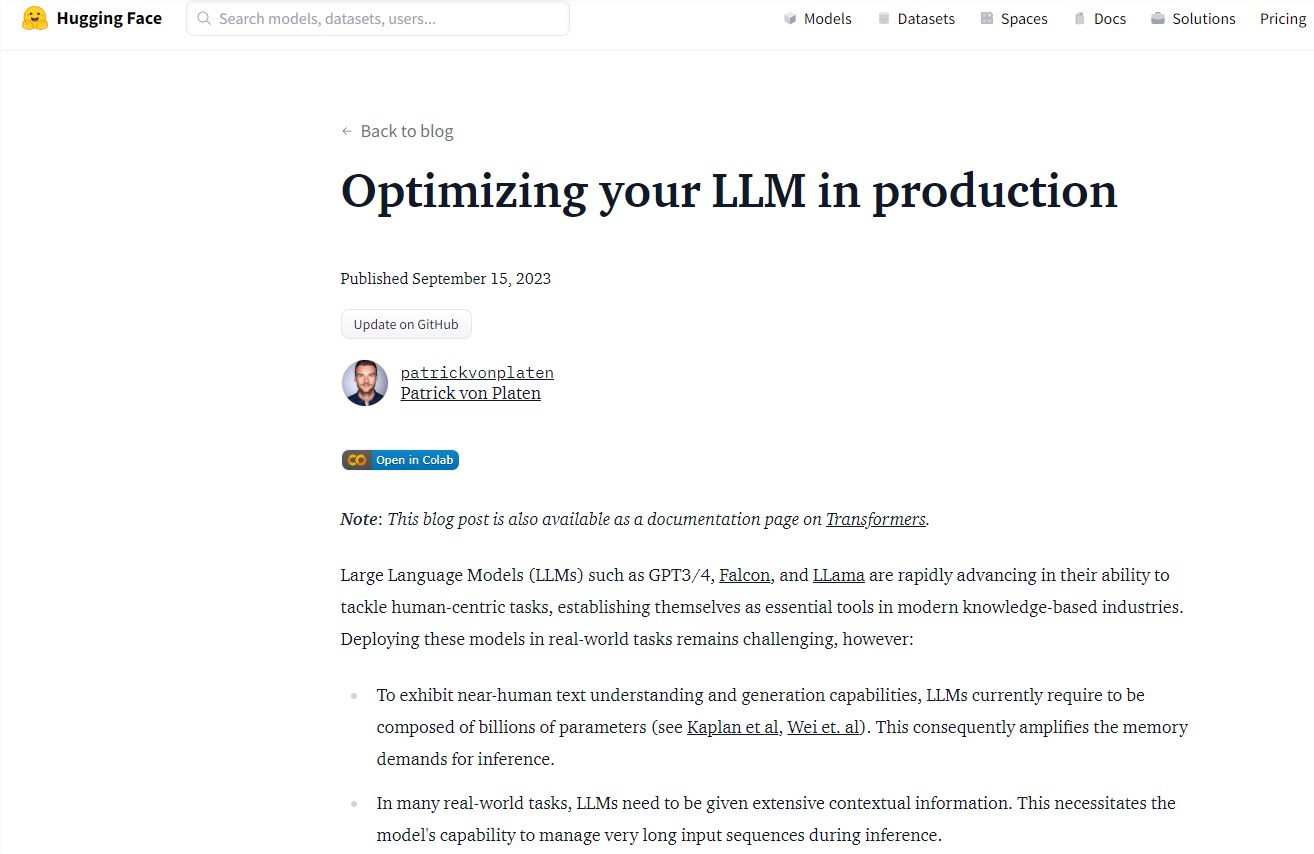

大语言模型的生产部署面临着两个主要挑战:一是需要庞大的参数量,二是需要处理超长的上下文信息输入序列。Hugging Face 基于他们在提供大型模型服务方面的经验,分享了一些应对这些难题的技术。

在 Patrick von Platen 的文章中,他介绍了三种 Hugging Face 研究的技术,分别是降低数值精度、采用 Flash Attention 注意力算法,以及利用专门的推理架构。

1. 降低模型数值精度,从float32切换到bfloat16,甚至将权重量化为8位或4位。这可以显著减少模型所需的内存空间。

2. 使用Flash Attention算法,它可以在线性内存增长的情况下处理更长的输入序列。该算法数学效果相同,但速度更快,内存效率更高。

3. 选择合适的模型架构,如相对位置编码(RoPE、ALiBi)和键值缓存(MQA、GQA),可以更好地处理长文本输入。

通过这三种技术的应用,Hugging Face成功优化了大语言模型在生产环境中的部署。文章详细介绍了每种技术的原理、效果对比,并给出实际应用案例。总体来说,文章深入剖析了大语言模型优化的关键技术点,对于产业实践具有重要参考价值。

参考文章:https://huggingface.co/blog/optimize-llm

0001

评论列表

共(0)条相关推荐

- 0000

- 0002

- 0000

- 0000

- 0001