ToRA:融合自然语言推理与外部工具 数学推理能力增强

文章概要:

- 清华大学与微软合作开发的ToRA是一款革命性的工具集成推理代理,旨在通过将自然语言推理与外部计算工具结合,解决复杂数学问题。

- ToRA模型经过训练,成功在多个数学推理数据集上取得了显著的性能提升,特别是在MATHS竞赛级数据集上,表现出高精度。

- 这一研究为数学问题求解领域带来了重大突破,通过无缝集成自然语言理解和工具使用,ToRA代理在各种数学推理任务上实现了最先进的性能。

随着大型语言模型的出现,人工智能和数学问题求解领域取得了显著进展。然而,这些模型在面对复杂的数学挑战时仍然存在问题。为了解决这个问题,清华大学与微软的研究人员推出了ToRA,这是一种被称为“工具集成推理代理”的创新方法,旨在通过将自然语言推理与外部计算工具相结合,解决复杂的数学问题。

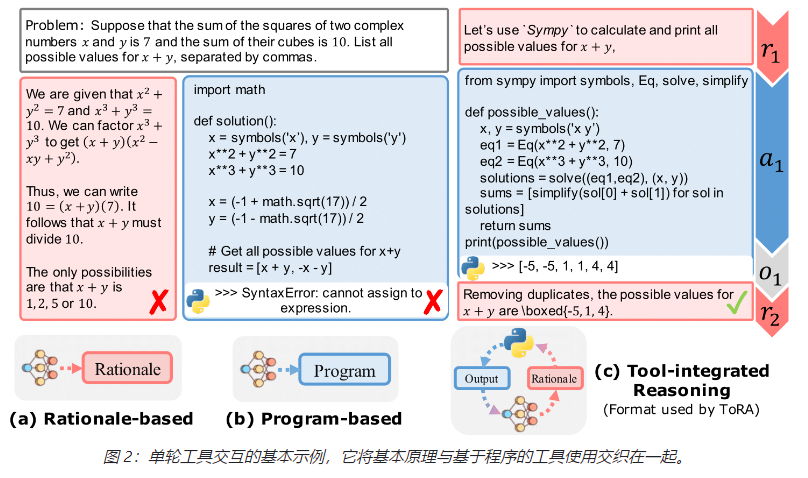

研究人员已经开始将外部工具,如计算器、代码解释器和符号求解器,集成到数学问题求解中。虽然基于程序的方法已经成功地将推理任务转化为程序合成任务,但它们仍然面临着复杂的推理、规划和错误处理问题。将大型语言模型(LLMs)与这些工具相结合显著提高了推理和生成性能。知识蒸馏技术,如LLM生成的轨迹用于微调,也在将知识从教师模型传递给学生模型方面发挥了作用。

尽管LLMs在语言任务中取得了显著进展,包括数学推理,但复杂的数学问题仍然具有挑战性。目前提高LLMs数学能力的策略包括逐步的自然语言推理和程序合成。前者在语义和抽象推理方面表现出色,而后者在严格操作中表现出色,并可以利用诸如方程求解器之类的专业工具。他们的方法在数学推理数据集上优于开源模型,在竞赛级MATHS数据集上取得了高精度。他们的方法还提供了关于工具交互的优势和未解决问题的见解,指导了该领域未来研究的方向。

ToRA模型是通过在数学数据集上使用交互式工具使用轨迹进行训练的,采用模仿学习进行注释,并通过输出空间塑造来改进推理行为。GPT-4在训练集上生成了多样化的推理模式。指导性和少样本示例以交织的格式进行组合,用于提示的策划,并评估了ToRA代理的效果,它将理性与程序相结合。这一方法取得了显著的推理性能提升。所面临的挑战包括更深入地理解几何空间以及解决中级代数和预微积分问题中的复杂符号推理。

ToRA通过将自然语言推理与外部工具相结合,增强了数学推理的能力。ToRA模型在十个数学推理数据集上表现出色,平均在程序化问题求解中超过开源模型13%-19%的绝对性能改进。他们的方法分析了工具交互的优势和挑战,突显了ToRA的工具集成推理格式的有效性,该格式将理性与程序执行相互交织。

ToRA代理代表了数学问题求解领域的重大突破,通过无缝集成自然语言理解和工具使用,它在各种数学推理任务上实现了最先进的性能,超过了现有的理性和基于程序的方法。对工具交互的优势和挑战进行的全面分析为未来的研究提供了重要见解,有望开发更先进和适应性更强的推理代理。

项目网址:https://github.com/microsoft/ToRA

- 0000

- 0000

- 0000

- 0000

- 0000