中国研究人员提出DualToken-ViT:CNN和视觉Transformer的融合,提高图像处理效率和准确性

要点:

1、DualToken-ViT将卷积和自注意力联合使用,分别提取局部和全局信息,再将两者输出融合形成有效的注意力结构。

2、使用位置感知全局令牌提升全局信息质量,令牌中还包含图像位置信息,有利于视觉任务。

3、在相同FLOPs下,DualToken-ViT在图像分类、目标检测和语义分割任务上表现最好。

最近,视觉Transformer(ViT)成为各类视觉任务如物体识别和图片分类的有效架构。这是因为自注意力可以从图片中提取全局信息,而卷积核大小限制了卷积神经网络(CNN)只能提取局部信息。随着ViT模型和数据集规模的增大,相比CNN具有更好的扩展性。但在轻量级模型上,由于缺乏某些归纳偏置,CNN优于ViT。

自注意力的二次复杂度导致ViT计算成本潜在很高,构建轻量高效的ViT并不容易。为此,提出金字塔结构,将模型分为多个阶段,每阶段令牌数减少,通道数增加,以构建更轻量高效的ViT。简化自注意力结构以减轻其复杂度,但以牺牲注意力有效性为代价。一个典型策略是下采样自注意力的key和value,减少参与注意力过程的令牌数。

论文地址:https://arxiv.org/abs/2309.12424

本研究中,华东师范大学和阿里巴巴集团的研究人员提出了紧凑高效的视觉Transformer模型DualToken-ViT。他们的方法使用卷积和自注意力联合提取局部和全局信息,再将两者输出融合形成有效的注意力结构。尽管窗口自注意力也可以提取局部信息,但他们发现,在轻量模型上卷积更有效。他们采用逐步下采样的方式生成key和value特征图,在下采样过程中保留更多信息,降低自注意力在传播全局信息时的计算成本。

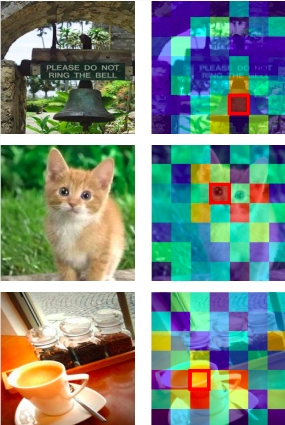

此外,他们在每个级别使用位置感知全局令牌来提高全局数据质量。与标准全局令牌不同,他们的位置感知全局令牌还可以维护和传递图像位置信息,在视觉任务中为模型提供优势。如图1所示,图像中的关键令牌与位置感知全局令牌中的对应令牌产生了更大的相关性。

总之,他们的贡献有:1)提出了紧凑高效的视觉Transformer模型DualToken-ViT,通过卷积和自注意力的优势实现有效的注意力结构;2)提出位置感知全局令牌,通过图像位置信息来增强全局信息;3)DualToken-ViT在相同FLOPs下在多个视觉任务上表现最好。

- 0000

- 0001

- 0000

- 0000

- 0000