揭开多模态神经元的秘密:从 Molyneux 到 Transformers 的过程

要点:

1. Transformers是人工智能领域最重要的创新之一,通过自注意机制实现并行处理,从而能够捕捉信息序列中的隐藏关系,加速训练并提高性能。

2. 通过跨模态任务,人工神经网络在语言和视觉等领域展现出强大的潜力,能够集成不同感官输入,取得出色的性能。

3. 最新研究表明,多模态神经元在Transformer模型中出现,可以处理图像和文本信息,对于实现多模态理解具有重要作用,对于游戏策略预测到蛋白质设计等多个任务具有广泛的应用前景。

近年来,Transformers成为了人工智能领域最重要的创新之一。这种神经网络架构于2017年推出,彻底改变了机器理解和生成人类语言的方式。

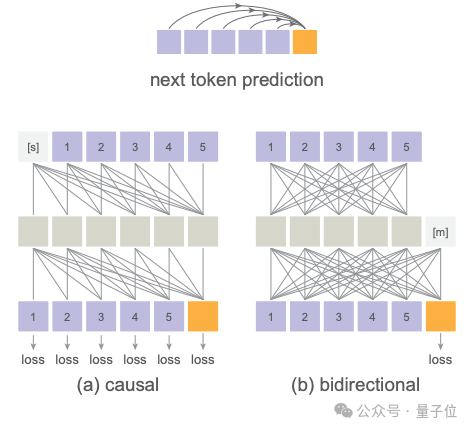

与它们的前身不同,Transformers依靠自注意机制并行处理输入数据,使它们能够捕捉信息序列中的隐藏关系和依赖性。这种并行处理能力不仅加速了训练时间,还为开发具有高度复杂性和性能的模型打开了道路,比如著名的ChatGPT。

论文地址:https://arxiv.org/pdf/2308.01544.pdf

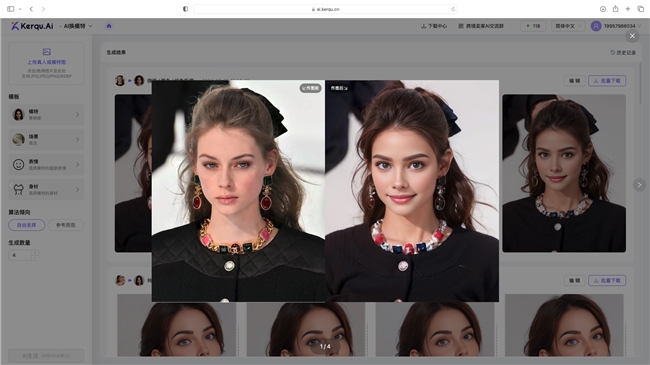

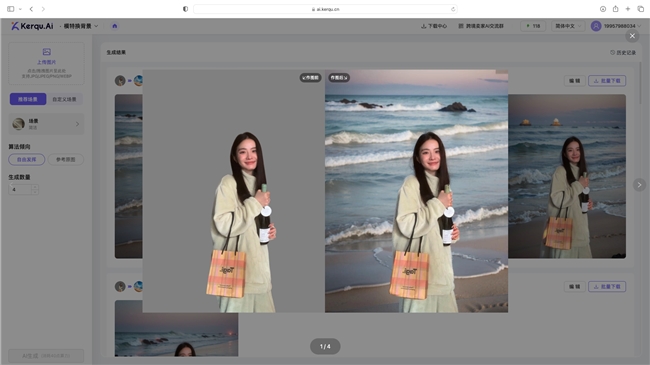

近年来,我们已经看到人工神经网络在各种任务中的出色表现。它们改变了语言任务、视觉任务等领域。但真正的潜力在于跨模态任务,它们整合了各种感觉模态,如视觉和文本。这些模型已经通过额外的感觉输入进行增强,在需要理解和处理来自不同信息源的任务上取得了令人印象深刻的性能。

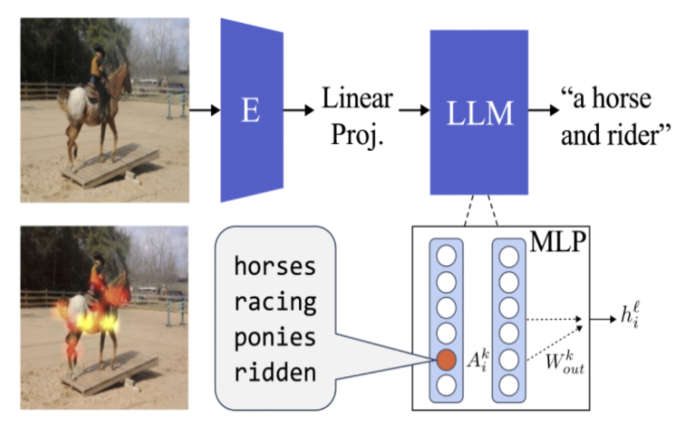

这一研究揭示了深度网络中个体单元内部运作的丰富信息。正如图像分类器中的卷积单元可以检测颜色和图案,随后的单元可以识别物体类别一样,Transformers中出现了多模态神经元。这些神经元对具有相似语义的图像和文本具有选择性。

此外,即使视觉和语言分别学习,多模态神经元仍然可以出现。它们能够有效地将视觉表示转化为连贯的文本。这种在不同模态之间对齐表示的能力具有广泛的影响,使语言模型成为各种需要序列建模的任务的强大工具,从游戏策略预测到蛋白质设计。这一研究不仅揭示了多模态模型的内部机制,还为机器跨模态理解和生成提供了深刻的见解。这有望推动人工智能在多模态智能应用中的发展。

- 0000

- 0000

- 0002

- 0000

- 0000