DeepMind研究人员发现,深度学习模型在图像和音频压缩方面表现出色

文章概要:

1. DeepMind研究人员发现,深度学习模型在文本领域之外,出人意料地在图像和音频数据的压缩方面表现出色。

2. 研究发现,虽然主要训练于文本数据,但这些大型语言模型(LLMs)在图像和音频数据的压缩方面表现出令人瞩目的性能,甚至超过了专门的压缩算法。

3. 将LLMs从压缩的角度看待为数据压缩器,为评估模型性能和规模提供了新的洞察,对模型的大小和性能之间的关系提供了重要见解。

近日,Google旗下的人工智能子公司DeepMind发布的一项研究表明,大型语言模型(LLMs)除了在文本数据处理方面表现出色之外,还具备出色的图像和音频数据压缩能力。这一发现为重新审视LLMs的潜力提供了新的角度。

研究的核心观点是将LLMs视为强大的数据压缩器,而非仅仅是文本生成模型。研究作者提出“通过压缩的角度来看待预测问题”,这为我们理解这些模型的能力带来了全新的视角。

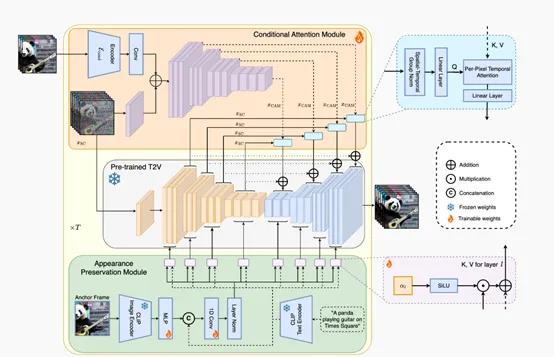

在研究中,DeepMind的研究人员对LLMs进行了一些微小的修改,使其能够执行算术编码,这是一种无损压缩算法。值得注意的是,LLMs的训练过程是基于对文本序列的极大概率和交叉熵的最小化,这使得它们能够生成概率分布,与数据压缩之间存在一对一的等价关系。这种无损压缩算法,如gzip,可以从压缩的数据完美重构原始数据,确保不丢失任何信息。

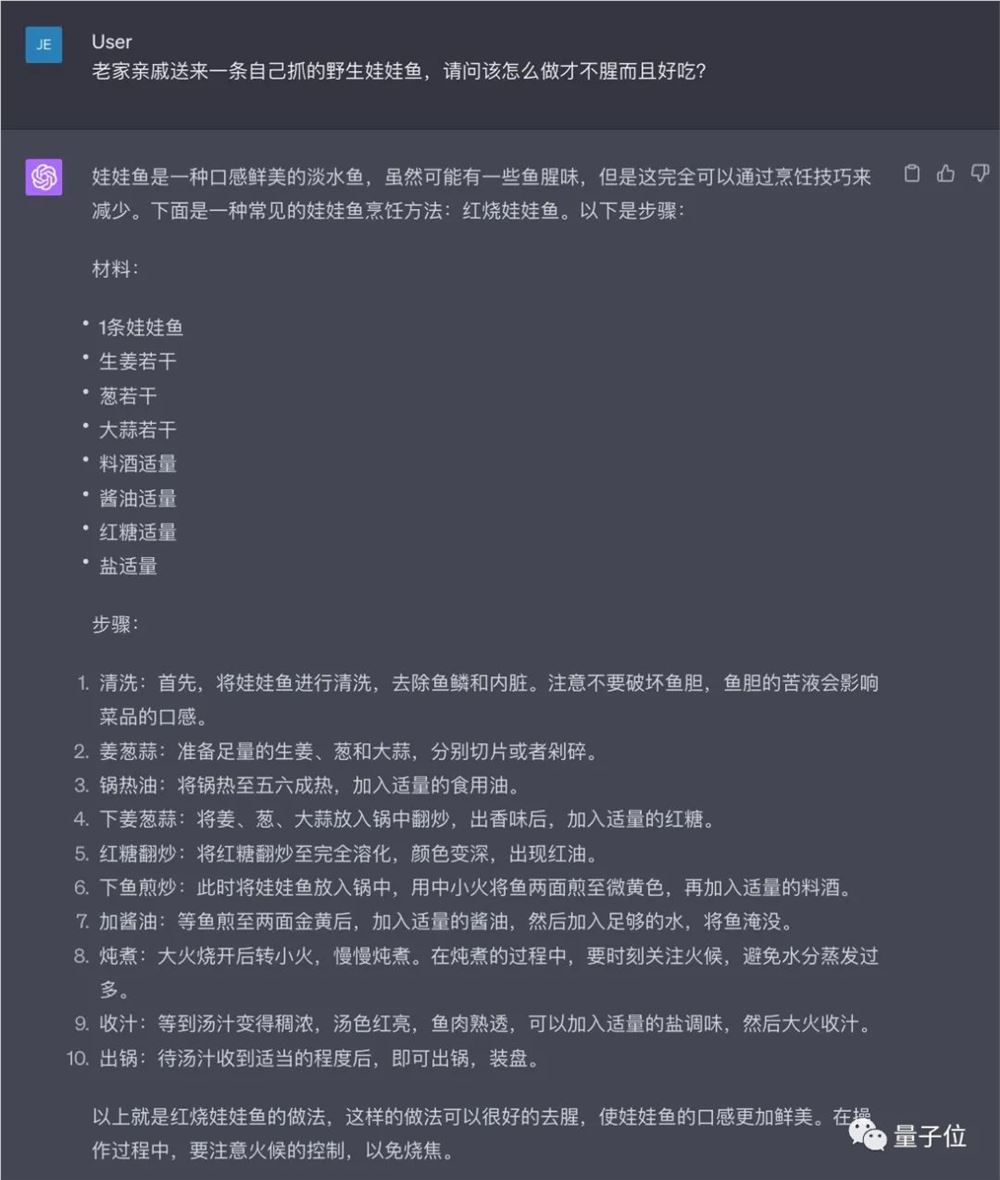

研究人员对LLMs在文本、图像和音频数据上的压缩能力进行了评估。不出所料,LLMs在文本压缩方面表现出色。例如,Chinchilla模型(拥有700亿参数)将数据压缩到原始大小的8.3%,远远超过gzip和LZMA2,它们分别只能实现32.3%和23%的压缩率。

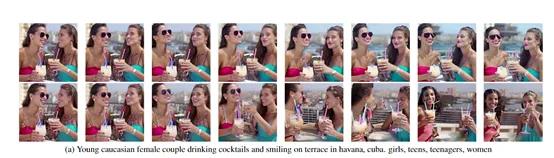

然而,更引人注目的发现是,尽管LLMs主要在文本数据上进行训练,但它们在图像和音频数据的压缩方面也取得了显著的成功,超过了领域专用的压缩算法,如PNG和FLAC。

尽管取得了令人鼓舞的结果,但与现有的压缩模型相比,LLMs在实际数据压缩中并不实用。这是因为LLMs的体积较大,运行速度较慢。例如,研究人员发现,gzip可以在CPU上在不到一分钟内将1GB的文本数据压缩,而具有320万参数的LLM需要一个小时才能完成相同数量数据的压缩。

研究还发现,LLMs的规模对其性能有重要影响。虽然一直以来,人们普遍认为越大的LLMs性能越好,但研究人员发现,对于较小的数据集,更大的模型并不一定更好。这表明LLMs的性能与数据集的大小有关,压缩率可以作为评估模型对数据集信息学习的指标。

- 0000

- 0000

- 0000

- 0000

- 0000