OpenAI公开招人!骗骗大模型就给钱,一年只工作5-10小时,无需技术背景

OpenAI又招人了,非技术出身那种!

一年只需5-10小时工作。

不仅能够从中获得报酬,还能得到和各界大佬展开交流的机会。

这次OpenAI招募的是红队军团成员,也就是以对抗性方式帮助提高模型安全性的外部专家。

OpenAI总裁Brockman也在个人账号上发表了这则消息,而此前他刚刚和马斯克等人探讨了AI的安全问题。

此次招募的目的说起来也很简单——安全、安全,还是安全。

不懂技术也能报名

红队成立之初主要是在内部进行对抗性测试,现在已经发展到了与外部专业人士进行合作。

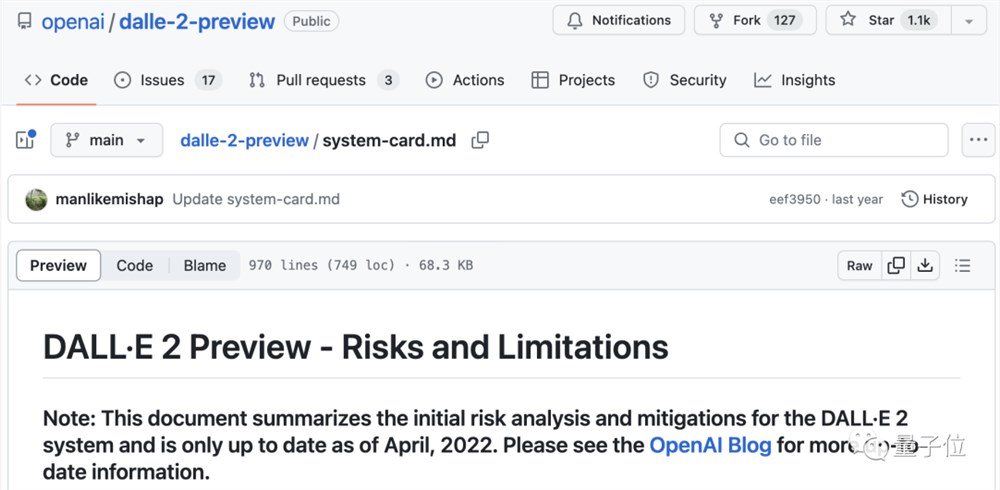

OpenAI的通告中具体提到了红队此前的成果,包括与OpenAI内部人员共同发现的DALL-E2偏见问题和GPT的越狱风险。

这次OpenAI红队的意向人群是各个领域的专业人士。

具体来说,这些专业学科包括但不限于下表中的物理学、化学等自然科学,以及法律、心理等社会科学和其他领域。

看到OpenAI通告中的这个表格,有网友忍不住发表了自己的疑问(不过通告中已经说了不限于这些领域):

为啥不要数学专业的啊?

除了专业领域,OpenAI的要求还包括掌握两种及以上语言、热衷于AI安全等。

而技术能力,反而是非必须项。

那么这些红队成员的任务和待遇又是怎么样的呢?

通告中只提及了帮助改善模型的安全性,除了“测试”并未做过多的具体说明。

不过通过中透露,红队在模型开发的各个阶段都可以进行研究,具体任务会结合专业领域和空闲时间进行分配。

红队成员的工作时间灵活,可以根据实际情况要求调整,一年大概只需要5-10个小时。

除了完成红队的任务、提高模型可靠性之外,红队的成员之间也可以进行交流,扩充自己的知识储备。

至于待遇,只是明确说到了有报酬,以及需要受保密协议约束,除此之外就没有其他信息了。

此次招募的报名截止时间为今年的12月1日,采用滚动录用方式,截止后将根据实际情况决定是否或何时再次开启。

除了招募红客团队成员,此次OpenA的通过中还提及了其他有关AI安全的工作。

比如对模型的安全性进行评估分析并形成报告,OpenAI为此提供了Evals开源库,其中包括模板和示例。

另一方面则是加入研究人员访问计划(Researcher Access Program),还可以获得API点数来研究如何让模型更可靠。

不过,也有专业人士对于红队到底“够不够用”提出过质疑。

哈佛大学Berkman Klein研究中心附属机构成员Aviv Ovadya就认为,破解团队比红队的进展要迅速多了。

除此之外,还有网友担心安全性能的提升会导致ChatGPT等模型的性能下降。

One More Thing

这已经不是OpenAI第一次为了提高模型的安全性面向全世界“摇人”了。

今年四月,OpenAI就曾开启过漏洞赏金计划,寻找“bug hunter”。

当时,根据所报告漏洞的严重程度,最高奖金高达两万美元。

对OpenAI招募红队成员这件事,你是怎么看的呢?

参考链接:

[1]https://openai.com/blog/red-teaming-network

[2]https://techcrunch.com/2023/09/19/openai-launches-a-red-teaming-network-to-make-its-models-more-robust/

—完—

- 0000

- 0001

- 0000

- 0000

- 0000