LLM Guard:增强LLM安全性的开源工具包 安全使用各种等模型

文章概要:

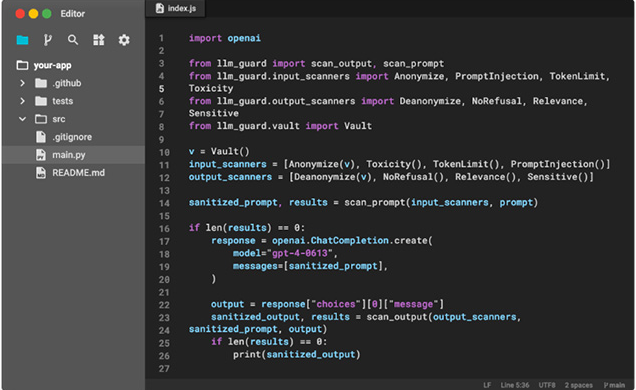

1. LLM Guard是一个旨在增强大型语言模型(LLMs)安全性的工具包,可轻松集成和部署在生产环境中。

2. 它提供了广泛的评估器,用于LLMs的输入和输出,包括清理、检测有害语言和数据泄漏,以及防止注入和越狱攻击。

3. 该工具包旨在简化公司对LLMs的安全采用,通过提供一站式的必要工具,希望成为市场首选的开源安全工具包。

LLM Guard是一个旨在增强大型语言模型(LLMs)安全性的开源工具包,旨在简化LLMs在企业中的安全采用。它的设计目的是为了轻松集成和部署在生产环境中,为LLMs的输入和输出提供广泛的评估,包括清理、检测有害语言和数据泄漏,以及防止注入和越狱攻击。

尽管LLMs具有提高员工生产力的潜力,但企业对其采纳一直持有疑虑。这种犹豫来自于LLMs存在的显著安全风险,以及在实施这些技术时缺乏控制和可观察性。

LLM Guard的一位创建者Oleksandr Yaremchuk表示:“我们希望成为市场首选的开源安全工具包,通过提供一站式的必要工具,简化公司对LLMs的安全采用。”

LLM Guard已经进行了一些令人兴奋的更新,包括更好的社区文档、对GPU推理的支持,以及最近在HuggingFace上部署的LLM Guard Playground。未来几个月内,他们计划发布安全API(LLM Guard的云版本),重点是确保低延迟性能和强化输出评估。

该工具包可以免费在GitHub上获得。无论使用ChatGPT、Claude、Bard还是任何其他基础模型,现在都可以加强LLM的安全性。

这一工具包的推出将有望促进大型语言模型在企业中的更广泛应用,为企业提供了更好的安全保障和可控性,从而更加自信地采用这一新兴技术。

项目网址:https://github.com/laiyer-ai/llm-guard

- 0000

- 0000

- 0000

- 0000

- 0000