谷歌内测员工称 Bard 为“病态的骗子”,为追赶 ChatGPT 不顾道德伦理?

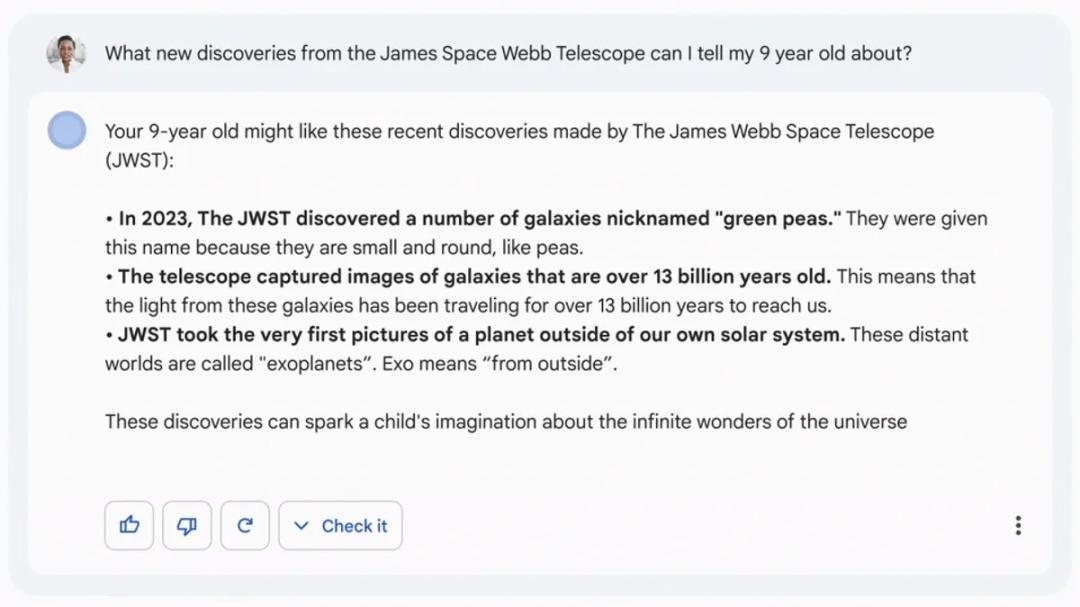

ChatGPT 一经面世就备受追捧,甚至成为各大企业竞相追逐的目标,而一直走在 AI 前沿的 Google 在发布 Bard 后却接连翻车,甚至引来自家员工的吐槽。根据内部讨论的截图,谷歌一位员工称 Bard 是个“病态的骗子”。另一个员工表示 Bard“令人尴尬”。一位员工写道,当他们向 Bard 询问如何降落飞机时,它却给出了导致坠机的建议;另一位员工则表示,Bard 提供的关于潜水的建议“可能会导致重伤或死亡”。

为追赶ChatGPT,将道德伦理置之不顾

在2020年底和2021年初,因为撰写了一篇批评大型人工智能模型(包括谷歌开发的模型)危害的研究论文,谷歌裁掉了公司的两名研究人员 Timnit Gebru 和 Margaret Mitchell。

丑闻发生后,谷歌试图提高其公众声誉。2021年,谷歌承诺,要将研究 AI 伦理道德的团队成员扩大一倍,并投入更多资源评估 AI 技术的潜在危害。然而,在2022年11月,随着竞争对手 OpenAI 的聊天机器人 ChatGPT 的火爆出圈,谷歌高级管理层就发出了“红色警报”。在内部开始要求尽快将生成式 AI 技术集成旗下所有主要产品中。

员工们表示,谷歌的管理层决定,只要把新产品称为“实验”,公众就可以原谅他们的缺点。当月,谷歌人工智能伦理负责人 Jen Gennai 召开了创新小组会议,她表示为了加快产品发布的步伐,谷歌可能有必要做出一些妥协。

谷歌分别为几个重要类别的产品进行打分,看看这些产品是否准备好向公众发布。在儿童安全等一些领域,工程师仍然需要100% 解决潜在问题。在其他领域, Jen Gennai 表示,“我们可能只要到80分、85分,或更高的水平,就可以满足产品发布的需求。”

在一份声明中, Jen Gennai 表示,这不仅仅是她这个层级的决定。在团队做出评估之后,她“列出了潜在风险清单,并将分析结果”升级提交给产品、研究和业务线的高级管理层。她表示,该团队随后判断,“可以通过有限制的实验性发布的形式向前推进,包括继续进行预训练,提高安全围栏,以及做出适当的免责声明”。

在今年2月,谷歌就向公众展示了 Bard。Bard 刚一亮相,就犯了一个事实性错误。这场仓促演示的背后,带来的是信任危机,股价大跌,令谷歌颜面大失。

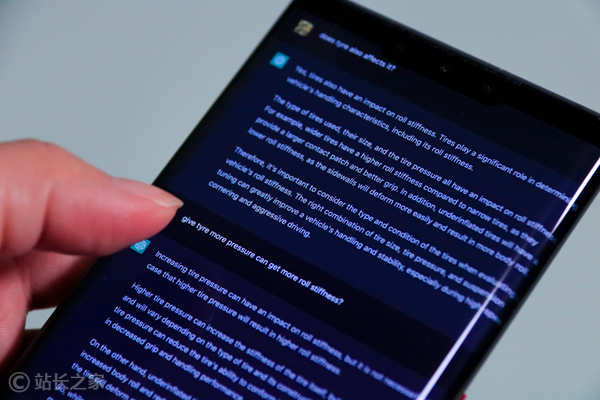

在一片批评声中,3月,Bard 正式开放公测。基于前期翻车事件的影响,多数用户对 Bard 的评价是平淡无奇,沉闷乏味,无法和 ChatGPT 相提并论。

负责谷歌新产品安全和道德伦理影响的员工透露,谷歌不希望员工做出任何阻碍人工智能技术开发的尝试,这就导致了现有团队成员士气低落,且没有发言权的窘境。此外,他们还表示,谷歌正在降低 AI 伦理的优先级,以便尽快发布能够击败 ChatGPT 的一款聊天机器人。

权益组织 Signal Foundation 主席、谷歌前经理梅雷迪思?惠特克 Meredith Whittaker 表示:“人工智能伦理已经退居次要地位。如果科技伦理不能被置于利润和增长之上,它们最终毫无意义。”

对此,谷歌表示,负责任的人工智能仍然是该公司的首要任务。“我们将继续投资于那些致力于将我们的人工智能原则应用于我们的技术的团队,”发言人 Brian Gabriel 说。

谷歌员工:“我们到底在做什么?”

整个硅谷仍在努力调和竞争压力与安全问题之间的关系。“人道技术中心(Center for Humane Technology)研究员在最近的一次演讲中表示,人工智能研究员和专注于人工智能安全的研究人员的数量之比达到30:1。这表明,在大型组织中提出对人工智能的担忧往往会孤掌难鸣。

随着人工智能的加速发展,人们越来越担忧人工智能对社会带来的不利影响。作为 ChatGPT 和 Bard 背后的技术,大语言模型从新闻报道、社交媒体帖子和其他互联网信息源处获得大量文字信息,随后用这些信息来训练软件,让软件根据用户的输入信息或问题自动预测并生成内容。这意味着,从本质上来看,这些产品都可能会出现有害或不准确的言论。

然而,随着 ChatGPT 引发的轰动,到今年年初,人工智能方面的发展已经无法回头。

2月,谷歌开始发布一系列的生成式人工智能产品,推出 Bard,随后升级了视频平台 YouTube。当时谷歌表示,YouTube 的创作者很快就可以在视频中进行虚拟换装,以及使用生成式人工智能创建“奇幻的电影场景”。两周后,谷歌云上线人工智能新功能,用于其各种工作空间应用程序,包括谷歌 Docs(文档)、Gmail、Sheets(表格)和 Slides(幻灯片)。同一天,谷歌还宣布将把生成式人工智能融入医疗健康产品线。谷歌员工们对此表示担心,认为这样的发展速度意味着谷歌没有足够的时间来研究人工智能潜在的危害。

是否应该以符合道德伦理的方式去开发尖端的人工智能技术,这一直是谷歌内部争论的一个话题。在过去几年里,谷歌产品的翻车事件备受瞩目。包括2015年错误地将黑人软件开发人员及其朋友的图像标记为“大猩猩”的尴尬事件。三年后,谷歌表示,没有修复底层的人工智能技术,而是删除了搜索关键词“大猩猩”、“黑猩猩”和“猴子”的所有结果。

不少员工表示,在谷歌从事人工智能伦理工作难度很大。一名前员工表示,他们曾要求解决机器学习公平性的问题,但不被支持,并且还会影响工作绩效。那些仍在谷歌从事人工智能伦理研究的员工则表示进退两难:如何既能保住自己在谷歌的工作,又能继续推进这方面研究。前谷歌的研究员 Nyalleng Moorosi 表示,人工智能伦理研究岗位的设立就是为了说明,技术没有做好大规模发布的准备之前,公司需要放慢速度。

据内部消息透露,到目前为止,除了一些研究论文的发表,以及谷歌云对客户合作和产品发布的审核,谷歌内部对产品和功能的人工智能伦理审核几乎完全是自愿形式。生物识别、身份识别,以及与儿童相关的人工智能研究必须由 Jen Gennai 的团队进行“敏感话题”审核,其他项目不一定需要。

尽管如此,当谷歌产品和工程团队试图了解为何谷歌的人工智在市场上进展缓慢时,他们会看到公众对人工智能伦理的关切。有一些员工表示,新技术应该尽快公布于众,可以快速获得反馈,也能够更快的更迭改进产品。

商业利益 or 社会责任 ?

一位谷歌前员工表示,在发出”红色警报“之前,谷歌的工程师可能很难掌握公司最先进的人工智能模型。他说,谷歌的工程师经常会通过研究其他公司的生成式人工智能模型来进行头脑风暴,来探索这项技术的可能性,随后再去研究如何在公司内部去实现这一技术。

“毋庸置疑的是'红色警报'和 OpenAI 推动谷歌带来了一些积极的变化,”前谷歌产品经理Gaurav Nemade 说。”他们真的能成为领导者,在自己的游戏中挑战 OpenAI 吗?”根据近期的一系列变化,比如三星正在考虑用微软的必应(Bing)取代谷歌作为其设备上的搜索引擎,其技术由 ChatGPT 提供支持,这就突显了目前市场上的先发优势。

谷歌的一些员工表示,他们认为谷歌已经对其新的生成式人工智能产品进行了足够的安全检查,并且 Bard 比竞争对手的聊天机器人更安全。

目前,研发新人工智能功能的团队正在封闭状态中,因此谷歌员工很难看到谷歌人工智能技术的全貌。以往,员工还可以通过公司的邮件组和内部频道来公开表达自己的疑虑,但现在谷歌以减少毒性为由提出了一系列社区指南,限制员工这样去做。几名员工表示,他们认为这些限制是控制言论的一种方式。

“这带来了挫败感。我们的感觉是,我们到底在做什么?”前人工智能伦理团队研究员 Margaret Mitchell 说。”即使谷歌没有明确的指令,要求停止道德伦理的工作,但在当前的氛围下,从事这类工作的员工会很明显的感觉到,自己不受支持,最终可能会因此减少工作量。“ 在谷歌管理层公开讨论道德伦理问题时,他们倾向于探讨假想的未来,即全能的技术无法被人类控制,而不太涉及已经可能带来危害的日常场景。这种做法也被一些业内人士批评为一种营销形式。

曾在谷歌担任研究科学家的 El-Mahdi El-Mhamdi 也因谷歌拒绝正面与其探讨人工智能伦理问题于今年2月从谷歌离职。他表示,去年底他参与合著的一篇论文提出,从数学上来看,基础性的人工智能模型不可能同时做到大规模、健壮,以及保障隐私安全。而谷歌通过雇佣关系对他参与的研究提出质疑。之后,他并没有为自己的学术研究辩护,而是直接放弃了与谷歌的雇佣关系,选择了学术身份。

“如果你想留在谷歌,你必须为系统服务,而不是与之矛盾。” El-Mhamdi 说。

- 0001

- 0000

- 0003

- 0000

- 0000