Groq最快AI推理芯片成本推算高得离谱 运行LIama2得1171万美元

划重点:

- 💰 以1171万美元的成本运行 LIama2,引发热议

- 💻 Groq 的芯片性能高,但成本也随之增加

- 🔍 分析师对 Groq 成本和效益进行评估,与英伟达 GPU 进行对比

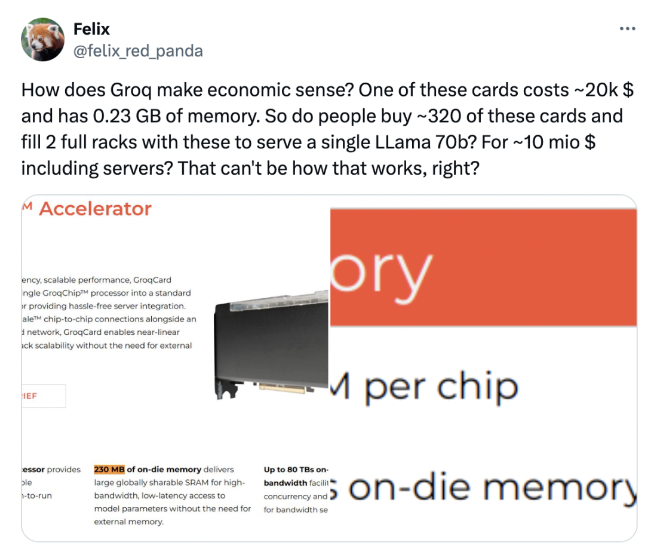

最近,Groq 公司推出了一款号称性价比高达英伟达 GPU100倍的 AI 推理芯片,引起了广泛关注。然而,运行其最快 AI 推理芯片 LIama2所需的成本高达1171万美元,让业内人士开始对其效益进行热议。网友们通过粗略估算发现,为了运行 LIama2,需要大约购买568块芯片,这一高昂的成本引发了许多讨论。

在成本问题上,与英伟达 GPU 进行对比也成为了焦点。据分析,为了运行单个 LLama70B 模型,需要购买约320张芯片,总成本约为1千万美元。相较之下,英伟达的 H100卡性能虽然一半于 Groq,但价格仅为30万美元,采购和运营成本更低。这些数据让人开始重新评估 Groq 芯片的性价比。

除了网友们的讨论,一些分析师也加入了对 Groq 芯片成本和效益的评估。根据其中一位分析师的计算,运行 LLaMA70b 模型需要572张芯片,每年电费将花费25.4万美元。相比之下,使用4张 H100卡可以实现 Groq 一半的性能,且采购和运营成本更低,这进一步凸显了 Groq 成本的挑战。

在这场关于 Groq 芯片成本和效益的讨论中,公司本身也积极参与。Groq 回应称,他们的目标客户不是单卡用户,且他们的芯片价格实惠高效,由于自主研发芯片到系统的整套流程,没有中间商。然而,对于 Groq 是否能撼动英伟达的地位,业内人士持观望态度,认为还需进一步观察。整体而言,Groq 推出的 AI 推理芯片在性能上取得了突破,但成本问题仍需解决。

项目入口:https://top.aibase.com/tool/groq

相关阅读:Groq大模型推理芯片每秒500tokens超越GPU,喊话三年超过英伟达

- 0000

- 0000

- 0000

- 0000

- 0000